Содержание

Из предыдущего обзора наши постоянные читатели знают, что 13 сентября 2012 года компания NVIDIA презентовала графические ускорители на GPU NVIDIA GeForce GTX 660, как оптимальный выбор в среднеценовом сегменте для геймеров с ограниченным бюджетом, желающих приобрести или обновить уже устаревшую видеоподсистему на более мощную. К сожалению, в нашу тестовую лабораторию ещё не попал «референсный» образец, однако в очередной раз партнёры калифорнийского гиганта порадовали нас, предоставив в короткие сроки семпл альтернативной версии ускорителя на основе графического процессора NVIDIA GeForce GTX 660.

В этом обзоре мы рассмотрим и протестируем видеокарту GIGABYTE GeForce GTX 660 2 ГБ GDDR5 WINDFORCE OC (GV-N660OC-2GD), имеющую фирменную систему охлаждению, переработанный дизайн платы и заводской разгон.

GIGABYTE GV-N660OC-2GD

NVIDIA GeForce GTX 660 (GK106)

Microsoft DirectX 11, OpenGL 4.3

Поддержка фирменных технологий

GPU Boost, Adaptive V-Sync, PhysX, SLI, NVIDIA Surround, 3D Vision, CUDA

Частота ядра, МГц

1033 (1098 МГц средняя частота с учетом использования технологии GPU Boost)

Частота памяти (эффективная), МГц

Объём памяти, МБ

Шина памяти, бит

До 2560×1600 Dual-link DVI

До 2048×1536 VGA (через переходник)

До 2560×1600 DisplayPort

До 2560×1600 HDMI

1x DVI-I Dual-Link DVI

1x DVI-D Dual-Link DVI

1x DisplayPort 1.2

1 x HDMI 1.4a

Поддержка HDCP и декодирования HD-видео

Есть

Декодирование MPEG-2, MPEG-4, DivX, WMV9, VC-1 и H.264/AVC. Дополнительный блок аппаратного декодирования NVENC.

Рекомендуемая мощность блока питания, Вт

Из данных таблицы со спецификациями можно сделать вывод, что перед нами переработанная версия графического ускорителя на основе NVIDIA GeForce GTX 660. Помимо альтернативной системы охлаждения и доработанного дизайна печатной платы, видеокарта GIGABYTE GV-N660OC-2GD имеет заводской разгон графического ядра. Его частота вместо эталонных 980 МГц составляет 1033 МГц (прирост 5%), которая в турбо режиме составляет в среднем 1098 МГц вместо «эталонных» 1033 МГц. Однако эффективная частота видеопамяти стандарта GDDR5 не была повышена в фабричных условиях и составляет «эталонные» 6008 МГц. Теперь непосредственно к упаковке.

Дизайн упаковки графического адаптера GIGABYTE GeForce GTX 660 2 ГБ GDDR5 WINDFORCE OC выполнен в лаконичном фирменном стиле с преобладанием черного цвета в оформлении. На лицевой стороне расположены эмблемы, информирующие о наличие 2 ГБ видеопамяти стандарта GDDR5, графическом ядре GeForce GTX 660, его заводском разгоне, а также наличие фирменной системы охлаждения WINDFORCE.

На обратной стороне коробки приведены краткие спецификации видеокарты на 9 языках (включая русский), а также расширенное описание особенностей фирменной системы охлаждения WINDFORCE и использующейся качественной элементной базы. Здесь же перечислены требования к системе, в которую планируется установка GIGABYTE GV-N660OC-2GD. Отметим, что блок питания в такой системе должен обладать мощностью не менее 450 Вт и быть способным выдавать 24 А по линии +12В.

Помимо самой видеокарты GIGABYTE GV-N660OC-2GD, в коробке мы обнаружили лишь краткую инструкцию по установке и переходник с двух 4-контактных периферийных разъёмов питания на 6-контактный разъём питания видеокарты. Так как это лишь тестовый семпл, поставляемый нам производителем для изучения, то в версии предназначенной для продажи комплектация будет расширена и будет включать ещё диска с драйверами и переходника DVI-to-VGA.

Набор портов для вывода изображения на видеокарте GIGABYTE GV-N660OC-2GD перекочевал от своих «старших» собратьев и имеет следующие разъёмы:

Для большинства пользователей такого набора интерфейсов будет вполне достаточно для повседневной эксплуатации. Приятно отметить, что разъёмы HDMI и DisplayPort имеют полноразмерное исполнение, что избавляет от необходимости использования дополнительных переходников даже при подключении нескольких дисплеев.

Дизайн печатной платы видеокарты GIGABYTE GeForce GTX 660 2 ГБ GDDR5 WINDFORCE отличается от предложенного инженерами NVIDIA. Впрочем, не возникает сомнений, что за основу при разработке был взят именно «эталонный» вариант.

Система стабилизации питания на видеокарте GIGABYTE GeForce GTX 660 2 ГБ GDDR5 WINDFORCE построена по 4+1-фазной схеме (для GPU и чипов памяти соответственно) с применением ШИМ-контроллера OnSemi NCP 5395G, также, в отличие от ZOTAC GeForce GTX 660 c 2 ГБ GDDR5 рассмотренной нами ранее, на каждую фазу выделяется по три полевых транзистора (MOSFET). Отметим, что при производстве видеокарты инженерами GIGABYTE применялись только качественные твердотельные конденсаторы японского производства, что должно положительно повлиять на срок службы продукта и нагрев цепей питания.

Помимо разъёма PCI-Express 3.0 дополнительное питание видеоускорителя GIGABYTE GV-N660OC-2GD обеспечивается через один 6-контактный силовой разъём, установленный на боковой стороне видеокарты.

Наличие разъёма для мостика SLI позволяет объединять две видеокарты на графическом процессоре NVIDIA GeForce GTX 660 любого производителя для совместного расчета графических эффектов и получения повышенной производительности.

Обратная сторона платы практически лишена элементов, за исключением двух танталовых конденсаторов, расположенных напротив графического ядра, четырёх чипов памяти, крепления системы охлаждения и несколько компонентов модуля VRM.

Графический чип NVIDIA GK106, произведенный с соблюдением норм 28 нм техпроцесса, является центральной частью рассматриваемой видеокарты. Он включает 960 универсальных шейдерных процессоров (или ядер CUDA по терминологии NVIDIA) и 24 блока растеризации, а обмен данными с видеопамятью осуществляется через 192-битную шину. Остальные характеристики чипа GK106 приведены на скриншоте выше.

Видеопамять стандарта GDDR5 общим объемом 2 ГБ набрана с помощью восьми чипов по 256 МБ производства компании SAMSUNG. Чипы имеют маркировку K4G20325F0-FC03 и согласно документации могут функционировать на эффективной частоте 6000 МГц.

Одной из ключевых особенностей видеокарты GIGABYTE GeForce GTX 660 2 ГБ GDDR5 WINDFORCE OC является применение фирменной системы охлаждения WINDFORCE 2X, которая, по заявлению производителя, охлаждает чип NVIDIA GK106 намного эффективнее «референсной» турбиной, издавая при максимальной нагрузке не более 31 дБ шума, что мы, безусловно, проверим чуть позже.

Для оптимального использования всей площади алюминиевого теплообменника, конструкция радиатора охладителя включает 4 тепловые трубки с внутренним сечением 8 мм, которые расположены на оптимальном удалении друг от друга и имеют следы пайки, как у основания, так и на рёбрах радиатора, что будет способствовать лучшему теплообмену. Обдув радиатора осуществляется с помощью двух низкооборотистых вентиляторов, которые имеют диаметр крыльчатки 100 мм. Силовые элементы преобразователя питания также взаимодействуют с радиатором через специальную термопрокладку, однако, чипы памяти не контактируют с радиаторами и охлаждаются лишь воздушным потоком.

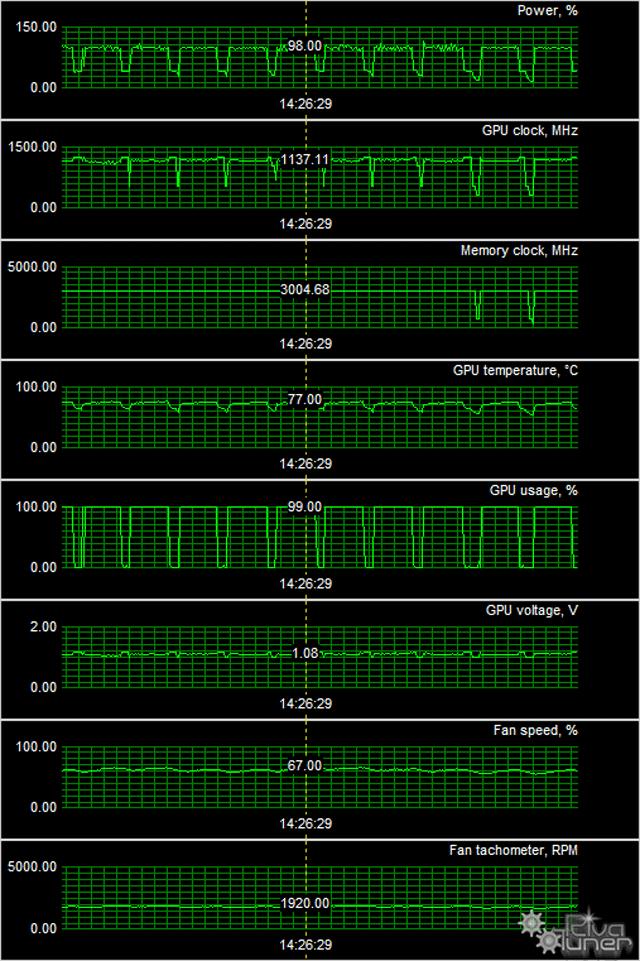

Для оценки эффективности применяемой системы охлаждения мы провели наш стандартный набор тестов с помощью утилиты MSI Kombustor. Тесты проводились в двух режимах работы кулера: автоматическое управление и максимальная скорость вращения вентиляторов.

При автоматическом регулировании скорости вращения вентиляторов, в режиме максимальной нагрузки графическое ядро нагрелось лишь до 61 градуса, а кулер, судя по показаниям мониторинга, работал при этом на 62% своей мощности, практически не издавая шума.

При максимальных оборотах вентиляторов, температура GPU снижается на 3 градуса, при этом шум от видеокарты практически не слышен, что свидетельствует о наличии большого «запаса эффективности» охладителя, которым мы обязательно воспользуемся во время ручного разгона.

При отсутствии нагрузки частоты графического ядра и памяти автоматически понижаются, что приводит к меньшему энергопотреблению и тепловыделению. Кулер в таком режиме работает почти бесшумно, а температура графического ядра не превышает отметку 32 градусов.

К сожалению, нам пока ещё не представилась возможность протестировать графический адаптер NVIDIA GeForce GTX 660 «референсного» дизайна, поэтому сравнить эффективность системы охлаждения напрямую с эталоном не получится. Однако эффективность СО WINDFORCE не вызывает сомнения, а её очень низкий уровень шума даже при максимальной нагрузке по достоинству оценят геймеры.

При тестировании использовался Стенд для тестирования Видеокарт №3

| Процессор | Intel Core i7-980X Extreme Edition (LGA 1366, 6 core, 3,33 ГГц, L3 12 МБ) @4,1 ГГц |

| Материнская плата | MSI Big Bang-XPower (LGA 1366, Intel X58 Express, DDR3, ATX) |

| Кулер | Cooler Master V8 (LGA 1366, 69,69 CFM, 2,94 мм H2O, 17-21 дБ) |

| Оперативная память | 3x 2 ГБ Kingston DDR3-2250 (KHX2250C9D3T1FK3/6GX) |

| Жесткие диски | 2x 128 ГБ Kingston SSDNow V+ (SNVP325-S2B/128GB) |

| Блок питания | Seasonic M12D-850 (850 Вт, 120 мм, 20 дБ) |

| Корпус | Antec LanВoy Air Yellow (MidiTower, Transformer) |

| Монитор | ASUS VG236H (Full HD, 1920×1080, 3D, 120 Гц) + NVIDIA 3D Vision Kit |

| Операционная система | Microsoft Windows 7 64-bit |

Выберите с чем хотите сравнить GeForce GTX 660 2GB GDDR5 GIGABYTE OC WINDFORCE

Благодаря небольшому заводскому разгону, по итогам тестирования, видеокарта GIGABYTE GV-N660OC-2GD продемонстрировала увеличенную производительность, в сравнении с практически «эталонными» возможностями видеокарты ZOTAC GeForce GTX 660. Однако в среднем частота смены кадров возросла не более чем на 2,5%, что никак не повлияло на итоговую расстановку сил.

Разгон

В процессе изучения эффективности системы охлаждения видеокарты GIGABYTE GV-N660OC-2GD мы выяснили, что применяемый кулер способен не только успешно справится с охлаждением энергоэффективного графического чипа NVIDIA GK106, но и имеет большой запас эффективности, который может пригодиться энтузиастам при экспериментах с оверклокингом.

Вооружившись утилитой MSI Afterburner, нам удалось разогнать графическое ядро до частоты 1086 МГц (прирост 5%), а эффективная частота памяти составила 6816 МГц (прирост 13%).Также важно отметить, что температура графического чипа не превышала 62 градуса. В таблице ниже вы можете оценить прирост производительности вследствие ручного разгона:

Futuremark 3DMark Vantage

Futuremark 3DMark 11

Crysis Warhead, DirectX 10, Maximum Quality, fps

Crysis Warhead, DirectX 10, Maximum Quality, AA4x/AF16x, fps

Far Cry 2, DirectX 10, Ultra Quality, NO AA/AF, fps

Far Cry 2, DirectX 10, Ultra Quality, fps

Aliens vs. Predator DX11 Benchmark, Maximum Quality, NO AA/AF, fps

Aliens vs. Predator DX11 Benchmark, Maximum Quality, AA4x/AF16x, fps

Colin McRae: DiRT 2, DirectX 11, Maximum Quality, NO AA/AF, fps

Colin McRae: DiRT 2, DirectX 10, Maximum Quality, AA4x/AF16x, fps

Metro 2033 Benchmark, DirectX 11, Maximum Quality, NO AA / AF4x, fps

Metro 2033 Benchmark, DirectX 11, Maximum Quality, AA4x/AF16x, fps

В среднем, благодаря ручному повышению частот нам удалось получить ещё 6,6% к производительности, что является далеко не рекордным показателем для решения среднего класса. Такую прибавку к быстродействию с трудом можно заметить невооружённым взглядом, и повлиять на итоговую расстановку сил в этом случае оверклокинг не может. Немаловажно, что разгонный потенциал нашего тестового семпла, судя по всему, ограничивался не эффективностью системы охлаждения, которая отлично справилась с рассеиванием большего количества тепла, а самими возможностями чипа NVIDIA GK106.

Выводы

Видеокарта GIGABYTE GeForce GTX 660 2 ГБ GDDR5 WINDFORCE OC (GIGABYTE GV-N660OC-2GD)в целом оставила о себе прекрасные впечатления. Фирменная система охлаждения WINDFORCE 2X отлично справляется с охлаждением чипа NVIDIA GK106, а её минимальный уровень шума позволит с полным комфортом наслаждаться звуковыми эффектами. Ещё достоинствами GIGABYTE GV-N660OC-2GD можно считать достаточно хороший уровень производительности, поддержку всех передовых технологий и полноразмерных разъёмов, как у «флагмана» GeForce GTX 680. Однако при всех его достоинствах ценовая политика, на сегодняшний день, не в пользу продуктов на GeForce GTX 660, поэтому и приобретение данной карты в ближайшее время мало оправдано с точки зрения цены/производительности. Как показывает практика, спустя некоторое время цена на видеокарты с графическим чипом GeForce GTX 660 перейдёт из разряда «новинки», из-за недавнего релиза, в разряд «оптимального средне ценового» продукта и тогда его приобретение будет более чем оправданно.

Введение

Появление нового поколения видеокарт NVIDIA GeForce GTX 660 следует считать радостным событием для тех, кто планировал приобрести новую видеокарту. Рекомендованная стоимость данных видеокарт находиться в районе 8500 рублей за экземпляр, при этом уже сегодня можно приобрести некоторые экземпляры видеокарт по 7500 рублей, а модифицированные варианты за 8000 рублей. Какова же производительность новинок и как их следует позиционировать?

Результаты тестирования новых видеокарт NVIDIA GeForce GTX 660 наглядно показывают, что данная видеокарта оказывается гораздо быстрее видеокарты GeForce GTX 570, о которой еще недавно мечтали многие геймеры. По результатам тестирования новинка оказывается не только быстрее, но и потребляет гораздо меньше электричества, соответственно рассеивая меньший уровень тепла.

Еще более интересными оказались результаты при сравнении новинки с GeForce GTX 580, который является флагманов продуктовой линейки прошлого года у NVIDIA. В номинальных режимах работы видеокарта NVIDIA GeForce GTX 660 не может опередить данную новинку. Но только стоит ее разогнать – по частоте ядра и видеопамяти, новинка начинает показывать сопоставимый и даже опережающий уровень производительности флагмана предыдущего поколения – NVIDIA GeForce GTX 580. Еще год назад последняя видеокарт предлагалась за 15 000 и более рублей, сегодня у пользователей имеется возможность за 50% данной стоимости получить более энергоэффективный, менее громоздкий продукт с практически аналогичным уровнем производительности после дополнительного разгона. Факт остается фактом – "старички" от компании NVIDIA прошлого поколения могут быть отправлены на покой, а появление нового решения за 7500-8000 рублей обвалит вторичный рынок графических решений на территории всей страны.

Если же говорить о продукции конкурента – AMD, то следует отметить, что до уровня производительности новинка от NVIDIA – GeForce GTX 660 не дотягивает до уровня AMD Radeon HD 7950, при этом настолько сильно, что назвать данный продукт конкурентом сего решения нельзя. Конкурирующим решением AMD Radeon HD 7950 является видеокарта NVIDIA GeForce GTX 660 Ti. Новая же видеокарта GeForce GTX 660 выпущена для того, чтоб нанести удар в ценовой сегмент видеокарт AMD Radeon HD 7850 и AMD Radeon HD 7870. Компании это удалось.

Еще перед анонсом новых видеокарт компанией NVIDIA – AMD начала снижать стоимость своей продукции. На сегодняшний день видеокарты AMD Radeon HD 7870 в исполнении MSI можно найти за примерные 8000 рублей. Ниже 7700 рублей даже OEM продукт на данный момент найти трудно, поэтому в плане ценовой категории – именно данный продукт является прямым конкурентом новинки NVIDIA GeForce GTX 660. Если же сравнивать производительность, то данные видеокарты показывают примерный паритет по уровню производительности в рамках разрешения 1920х1080, с незначительным перевесом в сторону новинки NVIDIA. Если же увеличить разрешение до 2560х1600 пикселей – имеющийся незначительный перевес смещается в сторону продукции AMD. Насколько это критично? Ни на сколько. Так как видеокарты данной ценовой категории не предназначены для игры при разрешении 2560х1600 пикселей – средняя частота кадров в большинстве игр не превышает 26-28 FPS. Данные видеокарты рассчитаны на запуск игрового приложения с включенными графическими эффектами на устройстве вывода изображения FullHD c разрешением 1920х1080 пикселей.

Так какую же видеокарту выбрать – AMD Radeon HD 7870 или NVIDIA GeForce GTX 660? До сих пор на данный вопрос нет окончательного ответа. Связано это с тем, что компании придерживаются паритетной ценовой политики. С одной стороны, видеокарты NVIDIA GeForce GTX 660 обладают не таким уж интересным разгонным потенциалом, учитывая наличие включенной технологии GPU Boost. У видеокарт AMD Radeon HD 7870 уровень разгона оказывается повыше, так как у них нет технологии GPU Boost. Изначально рабочая частота ядра видеокарт 1000 Мгц, а разогнанные с завода видеокарты нередко имеют частоту 1100 Мгц. Разгонный потенциал данных видеокарт из-за отсутствия технологий вида GPU Boost – также неплохой. К тому же, видеокарты AMD Radeon HD 7870 продаются уже больше 8-ми месяцев. За это время пользователям удалось выявить недостатки продуктов, указать AMD на устранение явных недостатков в драйверах. Выявленная ранее проблема "черных экранов" на данных видеокартах не приобрела массовый характер, а у кого выявлялась, нередко решалась обновлением драйверов или снижением рабочих частот после самостоятельного разгона. А что нам ждать от видеокарт NVIDIA GeForce GTX 660? Аналогичную или чуть большую производительность в номинальных режимах, наличие кучи статей с тестированием видеокарт, когда редактор сайта имеет опыт работы с решением не более 1 недели, а зачастую 2-3 дня, учитывая "высокий спрос со стороны редакций на продукт". Не следует забывать, что в отличии от NVIDIA GeForce GTX 660 Ti, решением GeForce GTX 660 основано на собственном новом ядре GK106, а не на урезанном GK104.

Итак, мы предлагаем вам взглянуть на видеокарту Gigabyte GeForce GTX 660 Windforce OC. Комплектация

Видеокарта Gigabyte GeForce GTX 660 Windforce OC поставляется в коробке черного цвета. Дизайн коробки стандартен для всех видеокарт серии WindForce, последнее указывает на наличие модифицированной системы охлаждения. На борту видеокарты распаяно два гигабайта видеопамяти типа GDDR5.

На оборотной стороне коробки видеокарты имеется подробная информация о внесенных модификациях, в частности, об особенностях системы охлаждения WindForce.

В комплектацию включена видеокарта, инструкция, переходник питания PCI-Express. С чем связана столь бедная комплектация продукта? Ответ достаточно прост. Если в сфере материнских плат Gigabyte ключевой игрок и основной конкурент ASUS, то в сфере графических решений отечественный пользователь нередко предпочитает продукцию Palit, Gainward продукции Gigabyte, не говоря уже о решениях ASUS. Данное обстоятельство связано с запятнанным прошлым видеокарт Gigabyte, когда продукты имели низкий разгонный потенциал и нередко вовсе выходили из строя даже еще в период гарантийных обязательств. На сегодняшний день продукция не вызывает каких-либо нареканий. А модифицированные версии видеокарт вообще очень интересны. Но Gigabyte продает свои видеокарты не особо дороже эталонных продуктов и именно это поддерживает высокий уровень спроса на данные видеокарты. А компания ASUS умудряется продавать свои решения по самой высокой цене и врятли думает о снижении их стоимости. Внешний осмотр видеокарты

Взяв в руки видеокарту Gigabyte GeForce GTX 660 Windforce OC в глаза бросается ее модифицированная система охлаждения с большими 90 мм вентиляторами охлаждения. За отвод тепла от ядра отвечают четыре тепловые трубки, которые осуществляют контакт через алюминиевую подошву. По тепловым трубкам тепло рассеивается на алюминиевом радиаторе.

Осадок оставляет тот факт, что система охлаждения WindForce стандартна и выступает за пределы самой печатной платы. Размеры печатной платы видеокарты настолько малы, что не понимаешь, за что тут могут просить 8000 рублей.

Видеокарта двухслотная. Она имеет стандартный набор портов вывода изображения: два DVI, один HDMI и один DisplayPort.

На боковой стенке видеокарты имеется один коннектор для подключения SLI мостика.

Несколько выше на боковой гране видеокарты имеется шестипиновый коннектор PCI-Express.

В качестве чипов памяти распаяны элементы Samsung типа GDDR5 с рабочей частотой 1500 Мгц и маркировкой K4G20325FD-FC03.

В качестве регулятора напряжения на плате распаян OnSemi NCP5395, который не поддерживает софтвольтмод. Спецификации видеокарты

1. Рабочая частота ядра: 980 МГц, турбо частота 1033 Мгц

2. Универсальных процессоров: 960

3. Тип памяти: GDDR5

4. Объем памяти: 2 Гб

5. Рабочая частота видеопамяти: 1502 МГц

6. Шина 192 битная

7. Шина PCI Express 3.0

8. Рекомендованная стоимость: $230 долларов для США

Видеокарта Gigabyte GeForce GTX 660 Windforce OC имеет заводской разгон по чипу до 1033 Мгц. Аналогичный уровень разгона имеют многие другие конкурирующие решения с заводским разгоном, например, у MSI. Тестовая конфигурация

1. Температурный режим работы видеокарты.

Видеокарта тестировалась при следующих условиях:

– в комнате 27 градусов,

– видеокарта установлена в закрытый корпус,

– в корпусе нет дополнительных вентиляторов охлаждения,

– нагрузка подается до полной стабилизации температур в течение 15 минут.

Результаты тестирования показывают, что система охлаждения WindForce несколько уступает системе охлаждения Twin Frozr на видеокартах MSI с аналогичными рабочими частотами. Без нагрузки систему охлаждения видеокарты практически не слышно, при увеличении нагрузки назвать ее назойливой также трудно.

2. Разгон видеокарты

Видеокарта Gigabyte GeForce GTX 660 Windforce OC по ядру смога покорить частоту 1122 Мгц, а по видеопамяти до 1684 Мгц. Аналогичные уровни разгонного потенциала показывают практически все представители данной серии видеокарт. Напомним, технология GPU Tweak не отключается, что сильно влияет на разгонный потенциал. Заключение

Видеокарта Gigabyte GeForce GTX 660 Windforce OC интересна для пользователей своей ценой. Ее стоимость чуть выше или даже на уровне эталонного продукта. При этом пользователь получает заводской разгон в сочетании с модифицированной системой охлаждения.

Содержание

Чем цена меньше — тем продукт ценнее, правда действует это правило не до бесконечности, ибо видеокарты, например, ценой около 100 долларов могут демонстрировать все возможности трехмерной графики уже в ограниченном варианте и на низких разрешениях. Поэтому как-то так сложилось на российском рынке, что наибольшим спросом пользуются ускорители ценой от 150 до 200 долларов. Настоящий обзор посвящен более дорогому продукту, недавно вышедшему Geforce GTX 660 Ti, однако он отличается тем, что обладает намного более привлекательной ценой, нежели топовые GTX 680/670, и при этом по производительности не сильно слабее, чем собрат GTX 670. В общем, полезность у 660 Ti явно выше, чем у 670/680.

Итак, сегодня мы изучим серийно выпускаемый продукт компании Gigabyte, основанный на указанном выше GPU. Про производителя, полагаю, рассказывать не надо — это известнейший и старейший мировой IT-бренд. Все карты Gigabyte, что мы изучали за последние годы, обладали как великолепными СО, так и хорошим соотношением цена-качество.

Плата

| Gigabyte Geforce GTX 660 Ti OC 2048 МБ 256-битной GDDR5 PCI-E (GV-N660TOC-2GD) | |

|---|---|

|

|

| Gigabyte Geforce GTX 660 Ti OC 2048 МБ 256-битной GDDR5 PCI-E (GV-N660TOC-2GD) | |

|---|---|

|

Карта имеет 2048 МБ памяти GDDR5 SDRAM, размещенной в 8 микросхемах (6 на лицевой и 2 на оборотной стороне PCB). Микросхемы памяти Hynix (GDDR5). Микросхемы рассчитаны на максимальную частоту работы в 1500 (6000) МГц. |

|

| Сравнение с эталонным дизайном, вид спереди | |

|---|---|

| Gigabyte Geforce GTX 660 Ti OC 2048 МБ 256-битной GDDR5 PCI-E (GV-N660TOC-2GD) | Reference card Nvidia Geforce GTX 670 |

|

|

| Сравнение с эталонным дизайном, вид сзади | |

|---|---|

| Gigabyte Geforce GTX 660 Ti OC 2048 МБ 256-битной GDDR5 PCI-E (GV-N660TOC-2GD) | Reference card Nvidia Geforce GTX 670 |

|

|

Мы видим, что дизайн у карты собственной разработки, инженеры Gigabyte постарались. Почему мы сравниваем с GTX 670? Да потому, что оба ускорителя основаны на одном и том же по сути GPU и на первый взгляд дизайн обеих карт схож. Видим 8 посадочных мест под микросхемы на лицевой стороне. Но если посмотреть на оборотную сторону, то увидим, что там посадочных мест только 4, а не 8, как у GTX 670. Это логично с точки зрения урезания шины обмена с памятью с 256 бит до 192 бит.

Однако, как мы уже говорили ранее, чтобы получить ускоритель с 256-битной шиной, при этом оснащенный объемом памяти в 2 ГБ, выпускается дизайн, предусматривающий монтаж 8 микросхем по 2 Гбит каждая, и они суммарно образуют 256-битную шину (8×32 бит). А чтобы получить 192-битную, надо просто на эту же карту недоустановить 2 микросхемы (комплектовать карту не 8, а 6 микросхемами), но тогда объем памяти получится 1,5 ГБ. Можно было бы пойти по тому же пути, что с GTX 550 Ti: поставить 4 микросхемы по 1 Гбит и 2 микросхемы по 2 Гбит каждая — суммарно получим объем 1 ГБ и 192-битную шину (благо контроллер памяти у чипов Nv > Видеокарта имеет стандартный для GTX 670/680 набор гнезд вывода: 2 DVI (один из которых Single-Link и совместим с выводом на VGA) и по одному DisplayPort и HDMI (второе гнездо DVI обладает возможностью через адаптер передавать сигнал на HDMI, поэтому суммарно можно подключить 2 приемника с HDMI). Напомним, что ускорители Nvidia достаточно давно обладают собственными звуковыми кодеками, поэтому передача на HDMI-монитор будет полноценной, со звуком.

Максимальные разрешения и частоты:

- 240 Гц — максимальная частота обновления;

- 2048×1536@85 Гц — по аналоговому интерфейсу;

- 2560×1600@60 Гц — по цифровому интерфейсу (для DVI-гнезд с Dual-Link/HDMI).

Карта имеет 4-фазную систему питания для GPU и 2 фазы на питании микросхем памяти. В принципе, все стандартно. Видимо поэтому в данном случае мы имеем дело не с SuperOverclock-версией, где обычно система питания всегда прецизионная и предусматривает ювелирные возможности для разгона, а просто с версией, где немного подняты частоты работы.

Что касается возможностей по ускорению декодирования видео, в 2007 году мы проводили такое исследование, с ним можно ознакомиться здесь.

Карта требует дополнительного питания, причем двумя 6-контактными разъемами.

О системе охлаждения.

| Gigabyte Geforce GTX 660 Ti OC 2048 МБ 256-битной GDDR5 PCI-E (GV-N660TOC-2GD) |

|---|

Данное устройство охлаждения продолжает традицию великолепных кулеров Gigabyte (мы не знаем, это полностью разработка конструкторов самой компании или же Gigabyte где-то заказывает такие устройства, но факт остается фактом — всякий раз, когда мы сталкиваемся с их системами охлаждения, то получаем только положительные ощущения от них).

СО состоит из трех радиаторов, соединенных меж собой двумя толстыми тепловыми трубками, проходящими прямо через подошву и соприкасающимися непосредственно с ядром GPU. Тепловые трубки разносят тепло по периферийным пластинам, при этом один из малых радиаторов прижимается к силовым транзисторам. Микросхемы памяти на лицевой стороне также охлаждаются. К сожалению, странно выглядит оставление двух микросхем на оборотной стороне без какого-либо охлаждения (какой смысл тогда вообще охлаждать их — или охлаждать все микросхемы, или ни одной).

Максимальные обороты вращения двух вентиляторов, обдувающих эти радиаторы, составляют 1900 оборотов в минуту. Это уже более критично, нежели мы наблюдали ранее, однако все равно шума практически нет, и СО подтвердила свой авторитет в плане бесшумности.

Мы провели исследование температурного режима с помощью утилиты EVGA PrecisionX (автор А. Николайчук AKA Unwinder) и получили следующие результаты:

| Gigabyte Geforce GTX 660 Ti OC 2048 МБ 256-битной GDDR5 PCI-E (GV-N660TOC-2GD) |

|---|

|

После 6-часового тестирования под нагрузкой максимальный нагрев ниже 80 градусов, собственно, для такого рода GPU это весьма хороший результат.

Теперь о комплектации.

Базовый комплект поставки должен включать в себя руководство пользователя, диск с драйверами и утилитами.

| Gigabyte Geforce GTX 660 Ti OC 2048 МБ 256-битной GDDR5 PCI-E (GV-N660TOC-2GD) |

|---|

На очереди рассмотрение упаковки.

| Gigabyte Geforce GTX 660 Ti OC 2048 МБ 256-битной GDDR5 PCI-E (GV-N660TOC-2GD) |

|---|

Установка и драйверы

Конфигурация тестового стенда:

- Компьютеры на базе процессора Intel Core i7-3960X (Socket 2011):

- процессор Intel Core i7-3960X (o/c 4 ГГц);

- системная плата Asus Sabertooth X79 на чипсете Intel X79;

- системная плата MSI X79A-GD45(8D) на чипсете Intel X79;

- оперативная память 8 ГБ DDR3 SDRAM Corsair 1866 МГц;

- жесткий диск Seagate Barracuda 7200.14 3 ТБ SATA2;

- жесткий диск WD Caviar Blue WD10EZEX 1 TБ SATA2;

- блок питания Enermax Platimax 1200 Вт.

Результаты тестов: сравнение производительности

В качестве инструментария мы использовали:

-

Hard Reset (Flying Wild Hog) — DirectX 11.0, для тестирования использовался встроенный в игру бенчмарк, все настройки выставлены на максимальное качество.

Благодарим компанию Nvidia за предоставление лицензионного продукта.

Total War: Shogun 2 (Creavive Assembly/SEGA) — DirectX 11.0, для тестирования использовался встроенный в игру бенчмарк, все настройки выставлены на максимальное качество.

Благодарим компанию Nvidia за предоставление лицензионного продукта.

3DMark’11 (FutureMark) — DirectX 11.0, настройки тестирования — Performance.

Aliens vs. Predator (2010) (Rebellion/SEGA), DirectX 11.0, настройки тестирования — Very High (запуск бенчмарка из меню).

Nexuiz (2012) (IllFonic/THQ) — DirectX 11.0, для тестирования использовался встроенный в игру бенчмарк, все настройки выставлены на максимальное качество.

Crysis 2 Maximum (Crytek/EA), DirectX 11.0, настройки тестирования — Very High, используется уровень Central Park. Бенчмарк запускался с помощью утилиты Adrenaline Crysis 2 Benchmark Tool.

Formula 1 (2010) (Codemasters) — DirectX 11.0, настройки тестирования — Ultra High (запуск бенчмарка: formulaone.exe -benchmark example_benchmark.xml).

Благодарим компанию Nvidia за предоставление лицензионного продукта.

Unigine Heaven Benchmark 2.0 (Unigine) — DirectX 11.0, скачать здесь, настройки тестирования — High.

Хотим отдельно поблагодарить коллектив компании Unigine и лично Александра Запрягаева за помощь в настройках работы бенчмарка.

DiRT Showdown (Codemasters) — DirectX 11.0, настройки тестирования — Ultra High (запуск бенчмарка: dirt showdown.exe -benchmark example_benchmark.xml).

Благодарим компанию AMD за предоставление лицензионного продукта.

Metro 2033 (4A Games/THQ) — DirectX 11.0, настройки тестирования — Super High, PhysX отключен (запуск бенчмарка в самой игре в виде отдельного файла).

Благодарим компанию Nvidia за предоставление лицензионного продукта.

Sleeping Dogs (United Front Games/Square Enix) — DirectX 11.0, для тестирования использовался встроенный в игру бенчмарк, все настройки выставлены на максимальное качество.

Все наши пояснения направлены, как правило, на новичков или неопытных пользователей, желающих, однако, произвести апгрейд своего компьютера или просто собрать новый.

Тем, кто вообще не понимает, что́ такое ядро, почему в нем столько процессоров, что́ такое потоки и прочее, имеет смысл ознакомиться с нашими краткими справочниками по семействам современных видеокарт и процессоров, на основе которых они выпускаются. Следует отметить частоты работы, поддержку современных технологий (шейдеры), а также конвейерную архитектуру.

А теперь посмотрим на тесты.

У нас представлены тесты GTX 660 Ti в двух режимах: на номинальных частотах и на повышенных до 1100 МГц по ядру. Продукт Gigabyte имеет промежуточные частоты, поэтому можно легко прикинуть его местоположение.

Выводы

Начнем с анализа Рейтинга ускорителей iXBT.com, который демонстрирует нам функциональность видеокарт друг относительно друга и нормирован по самому слабому ускорителю — Geforce GT 630 (то есть сочетание скорости и функций GT 630 приняты за 100%). Приведем выборку из этого рейтинга.

Рейтинг 3D-ускорителей iXBT.com

| № | Название ускорителя | Рейтинг iXBT.com | Рейтинг полез. | Цена |

| 10 | GTX 660 Ti 2048 МБ, o/c 1100—1200/6400 | 700 | 203 | 344 |

| 11 | HD 7870 2048 МБ, o/c 1150/1150/5500 | 640 | 194 | 330 |

| 12 | GTX 660 Ti 2048 МБ, 915—1030/6000 | 640 | 186 | 344 |

| 13 | HD 7950 3072 МБ, 800/800/5000 | 630 | 158 | 399 |

| 14 | GTX 580 3072 МБ, 783/1566/4040 | 620 | 146 | 424 |

| 16 | HD 7870 2048 МБ, 1000/1000/4800 | 570 | 173 | 330 |

Собственно, как мы видим, разогнанная версия GTX 660 Ti лидирует в рейтинге внутри своей группы. Да, не менее разогнанная версия конкурента HD 7870 нажимает на пятки, поэтому мы можем предположить, что наш случай с продуктом Gigabyte может и уступить первенство, но не более того. Посмотрите, что даже работающий на штатных частотах GTX 660 Ti обходит не только соперника в лице HD 7870, но и даже более дорогой HD 7950!

А теперь посмотрим Рейтинг полезности тех же карт (показатели предыдущего рейтинга делятся на цены соответствующих ускорителей):

Рейтинг полезности (возможности/цена)

| № | Название ускорителя | Рейтинг полез. | Рейтинг iXBT.com | Цена |

| 10 | GTX 660 Ti 2048 МБ, o/c 1100—1200/6400 | 203 | 700 | 344 |

| 12 | HD 7870 2048 МБ, o/c 1150/1150/5500 | 194 | 640 | 330 |

| 18 | GTX 660 Ti 2048 МБ, 915—1030/6000 | 186 | 640 | 344 |

| 25 | HD 7870 2048 МБ, 1000/1000/4800 | 173 | 570 | 330 |

| 27 | HD 7950 3072 МБ, 800/800/5000 | 158 | 630 | 399 |

| 31 | GTX 580 3072 МБ, 783/1566/4040 | 146 | 620 | 424 |

Как и следовало ожидать, и в данном случае мы видим, что GTX 660 Ti, работающий на повышенных частотах, попал в лидеры. Да, снова прижимает конкурент в лице HD 7870, но все же GTX 660 Ti выглядит предпочтительнее.

Теперь по самой карте.

Gigabyte Geforce GTX 660 Ti OC 2048 МБ 256-битной GDDR5 PCI-E (GV-N660TOC-2GD) — отличный вариант нового продукта среднего ценового диапазона (тяготеющего, если можно так сказать, к топовым уровням). Ускоритель имеет прекрасную СО, относительно небольшие размеры и обладает всеми нужными на сегодня гнездами вывода. Ну и еще раз напомню, что внутри своей группы GTX 660 Ti смотрится явным лидером.

Окончательное решение традиционно остается за нашими читателями. Мы лишь даем информацию о рассмотренных продуктах, но не делаем прямых указаний по выбору того или иного изделия.

В номинации «Оригинальный дизайн» (за октябрь 2012 года) получила награду карта: