В предыдущих статьях мы поговорили про мифы о процессорах, оперативной памяти и материнских платах, теперь же перейдем к видеокартам, которые уже давно стали обязательной частью любого компьютера.

Первый миф. Чем больше видеопамяти — тем быстрее видеокарта

Казалось бы, это логично — в более мощные видеокарты ставится больше памяти: так, GTX 1070 с 8 ГБ памяти быстрее, чем GTX 1060 с 6 ГБ, а GTX 1080 Ti с 11 ГБ быстрее GTX 1080 с 8 ГБ. Однако следует понимать, что видеопамять, конечно, важна, но зачастую различное ПО не использует всю имеющуюся у видеокарты память: так, в большинстве случаев GTX 1060 с 3 ГБ медленнее версии с 6 ГБ всего на 5-10%, и разница в основном идет из-за различного числа CUDA-ядер.

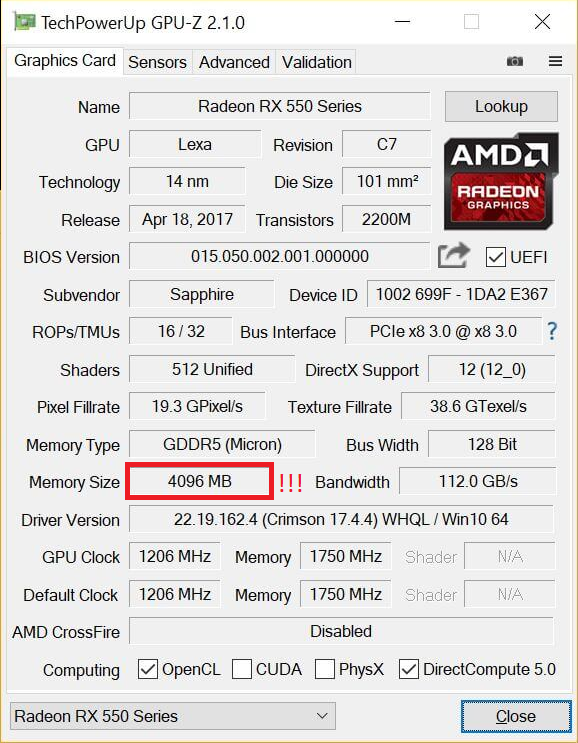

Но есть производители видеокарт, которые решили воспользоваться этим мифом в свою пользу: так, например, на рынке можно найти GT 740 с 4 ГБ GDDR5 памяти. Казалось бы — да у GTX 780 Ti, топовой видеокарты того поколения, всего 3 ГБ памяти — то есть GT 740, получается, лучше? Разумеется нет — на тех настройках графики, где используется столько памяти, эта видеокарта выдает слайд-шоу. Ну а если снизить уровень графики для повышения «играбельности», то окажется, что использовано от силы 1-2 ГБ памяти. Причем такие видеокарты встречаются и в текущих линейках — так, у AMD есть RX 550 с теми же 4 ГБ GDDR5 — с учетом того, что видеокарта выступает приблизительно на уровне GT 1030, очевидно, что использовать столько памяти она сможет в очень немногих задачах:

Так что не стоит судить о производительности видеокарты, опираясь только на объем видеопамяти.

Второй миф. Если видеокарте не хватит видеопамяти в игре, то обязательно будут фризы, вылеты и тому подобное

Опять же, это кажется логичным: если видеокарте памяти не хватило, взять ее больше неоткуда — значит, программы корректно работать не смогут. Однако на деле это, разумеется, не так — любая видеокарта имеет доступ к оперативной памяти, которой обычно куда больше, чем видеопамяти. Конечно, ОЗУ в разы медленнее, а время доступа к ней больше — это может вызвать проблемы с плавностью картинки, но только лишь в том случае, если собственной памяти видеокарте не хватает сильно: например, у нее 2-3 ГБ памяти, а игра требует 4-5 ГБ. Но если не хватает нескольких сотен мегабайт, то обычно это проблем не вызывает: GPU умеют динамически использовать доступные им ресурсы, и в ОЗУ они стараются хранить ту информацию, которая нужна редко или не требует мгновенного отклика.

Третий миф. От разгона видеокарты сгорают

При этом различные производители продают разогнанные с завода версии видеокарт. Разумеется, при разгоне видеокарта может повредиться — но только в том случае, если вы измените «физические» параметры, такие как напряжение. Изменение программных параметров, таких как частоты, никак на «железо» не влияет, так что максимум, что вы получите, это вылет видеодрайвера или BSOD от выставления слишком высокой частоты.

Четвертый миф. SLI/Crossfire увеличивают производительность и объем видеопамяти во столько раз, сколько видеокарт подключено

Насчет производительности это, скорее, не миф, а теоретический результат. Увы — на практике, хотя тому же SLI 20 лет, а Nvidia его использует больше 10 лет, в большинстве игр прирост или околонулевой, или вообще отрицательный. Лишь в единичных проектах можно получить прирост хотя бы 20-30% в сравнении с одной видеокартой, что, конечно, смешно, с учетом двукратного увеличения стоимости и серьезных требований к блоку питания. Что касается вычислительных задач, то тут все сложнее: так, профессиональный софт вполне может использовать несколько GPU эффективно, но это уже не домашнее применение.

Что касается видеопамяти, то тут все просто: при использовании DirectX 11 или ниже в видеопамять каждого используемого GPU записывается одинаковая информация, то есть у связки видеокарт будет по сути тот же объем памяти, что и у одиночной карты. А вот в API DirectX 12 есть возможность более эффективно использовать Split Frame Rendering, когда каждая видеокарта готовит свою часть кадра. В таком случае объемы видеопамяти суммируются — пусть и с оговорками.

Пятый миф. Профессиональные видеокарты лучше игровых

Миф идет от того, что профессиональные видеокарты (такие как Nvidia Quadro или AMD FirePro) стоят обычно сильно дороже пользовательских «игровых» видеокарт — а раз дороже, значит лучше. На практике вопрос только в том — в какой области лучше? С физической точки зрения большая часть профессиональных видеокарт имеют тот же GPU и тот же объем памяти, что и обычные игровые видеокарты, а разница идет только из-за других драйверов, которые больше заточены под профессиональное применение:

С учетом того, что эти драйвера под игры никто специально не адаптирует, то профессиональные видеокарты в играх зачастую будут несколько хуже аналогичных по производительности игровых GPU. С другой стороны, если мы будем сравнивать эти же видеокарты в различных CAD-ах или 3ds Max — перевес будет на стороне профессиональной графики, причем зачастую очень существенный. Так что ответ на миф таков: сравнивать эти видеокарты в лоб не имеет смысла, они «играют» и в разных ценовых сегментах, и в разных сценариях использования.

Шестой миф. Если видеокарта не раскрывается процессором — это плохо

Пожалуй, самый популярный миф, который гласит о том, что если видеокарта не занята на 100% — это плохо. С одной стороны, это кажется логичным: нагрузка ниже 100% означает, что видеокарта частично простаивает и вы недополучаете часть производительности. С другой стороны, многие забывают, что нагрузить GPU на 100% можно практически при любом процессоре. Как так? Очень просто: каждый процессор в каждой игре может подготовить для видеокарты лишь определенное количество кадров в секунду, и чем процессор мощнее — тем больше кадров он может подготовить. Соответственно, чтобы видеокарта была занята на 100%, она должна иметь возможность отрисовать меньше кадров в секунду, чем может дать ей процессор. Как это сделать? Да очень просто: поднять разрешение, поставить более высокие настройки графики, включить тяжелое сглаживание — и вуаля, GTX 1080 Ti в 5К на ультра-настройках графики «пыхтит», выдавая 15-20 кадров в секунду, а поставленный ей в пару двухядерный Intel Pentium едва ли нагружен на половину.

Легко можно получить и обратную ситуацию: взять ту же самую GTX 1080 Ti и запустить на ней игру в HD-разрешении с минимальными настройками графики — и тут даже Core i9-9900K не сможет подготовить для ней столько кадров в секунду, чтобы она была занята на 100%.

Так что тут можно сделать два вывода: во-первых, если видеокарта недогружена несильно, а итоговый fps вас устраивает — всегда можно еще немного увеличить настройки графики, чтобы получить 100% нагрузку на видеокарту с лучшей картинкой и при той же производительности. Во-вторых, собирайте сбалансированные сборки, дабы не было такого, что процессор занят на 100%, а fps в игре 20 кадров.

Седьмой миф. Чем уже шина памяти — тем ниже производительность видеокарты

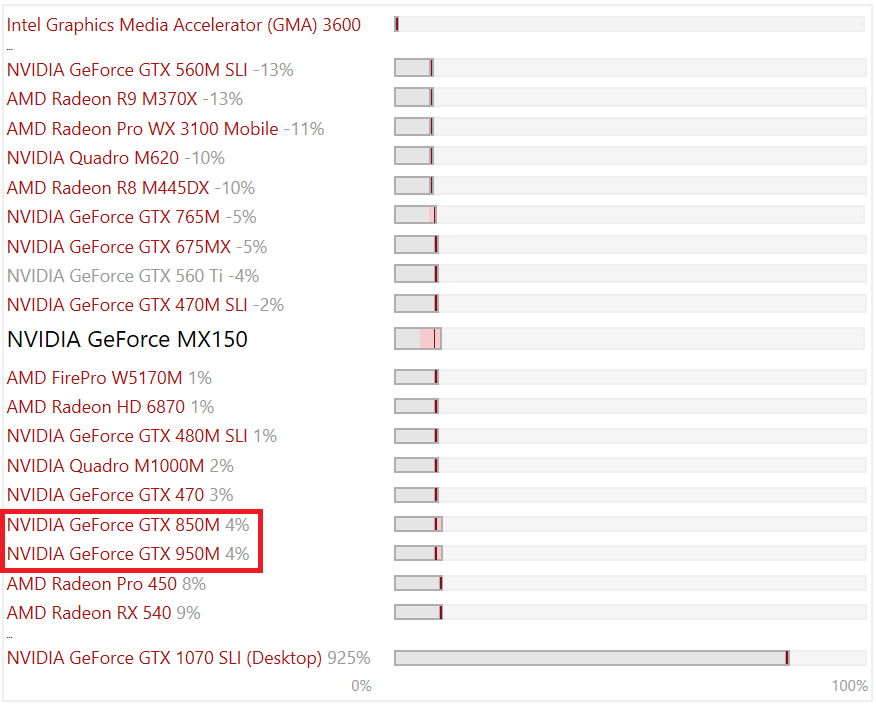

Очень часто на различных форумах можно встретить посты типа «вот, 8 лет назад у GTX 480 шина памяти была 384 бита, а сейчас у GTX 1080 всего 256, Nvidia экономит». Опять кажется, что это логично — чем шире шина, тем больше данных по ней можно «гонять». Но тут следует помнить две вещи: во-первых, не шиной единой: частоты памяти с того времени выросли в разы, во-вторых — производители GPU постоянно улучшают алгоритмы передачи данных по шине, что позволяет использовать ее более эффективно. Все это приводит к тому, что ширину шины можно безболезненно урезать: так, MX150 (она же GT 1030), имея шину всего в 64 бита (как один канал ОЗУ), способна при этом выдавать производительность уровня GTX 950M со 128-битной шиной, которая еще пару-тройку лет назад считалась среднеуровневой мобильной игровой видеокартой:

Восьмой миф. Если видеокарта не перегревается, то она работает на максимально возможной для нее частоте в рамках ее теплопакета

Увы — аналогия с процессорами тут не работает: если те действительно удерживают максимальные частоты в рамках TDP вплоть до температуры, с которой начинается троттлинг из-за перегрева, то видеокарты работают хитрее: так, у Nvidia есть технология GPU Boost, которая, с одной стороны, является аналогом Turbo Boost для процессоров — позволяет поднимать частоту выше базовой — а с другой стороны имеет больше ограничений.

Возьмем, для примера, GTX 1080 Ti. Она имеет родную частоту в 1480 МГц, а Boost — 1580. Но стоит нагрузить видеокарту, как частота может подскочить до 1800-1850 МГц — то есть выше Boost: это и есть работа технологии GPU Boost. Дальше — интереснее: критические температуры у видеокарт поколения Pascal составляют порядка 95 градусов — но уже при 85 можно заметить, что частоты снижаются ближе к уровню Boost. Почему так? Потому что Nvidia ввела еще одну опорную температуру, которую называет целевой: при ее достижении видеокарта старается ее не превышать, а для этого сбрасывает частоты. Так что если у вас мощная видеокарта, да и еще с референсным турбинным охлаждением — внимательно следите за температурами, ибо от них в прямом смысле зависит производительность.

Девятый миф. Видеокарты без дополнительного питания хуже аналогов с ним

В продаже можно встретить видеокарты уровня GTX 1050, 1050 Ti и AMD RX 550 без дополнительного питания — то есть, как в старые добрые времена, достаточно поставить их в слот PCIe и они готовы к работе. При этом также есть версии 1050 и 1050 Ti с дополнительным питанием 6 pin, из-за чего некоторые пользователи делают вывод, что раз дополнительное питание есть — значит с ним видеокарты будут работать лучше.

На деле это не совсем так: слот PCIe способен дать видеокарте до 75 Вт, и этого вполне хватает, чтобы даже 1050 Ti работала на указанных на официальном сайте Nvidia частотах. Но если вы нацелены на разгон — да, тут питания от PCIe видеокарте может уже не хватить, так что дополнительные 6 pin от блока питания позволят достичь больших частот, однако разница в любом случае не превысит 10%.

Десятый миф. Не стоит ставить современные PCIe 3.0 видеокарты на старые платы со слотами PCIe 2.0 или 1.0

Все опять же логично — так, пропускная способность PCIe 2.0 x16 вдвое ниже, чем у 3.0 x16, а, значит, современные видеокарты через более старую шину PCIe будут работать медленнее. На деле это опять же не так — пропускная способность PCI Express 3.0 x16 даже для топовых современных видеокарт оказывается избыточной:

Хорошо видно, что разница между 3.0 x16 и 2.0 x16 составляет всего 1%, то есть погрешность, и даже если спуститься до PCIe 1.1 — то есть к материнским платам почти десятилетней давности — падение производительности оказывается всего лишь 6%. Так что вердикт тут прост — версия PCIe практически не влияет на производительность видеокарты, соответственно можно смело к Xeon с PCI Express 2.0 брать GTX 1080.

Одиннадцатый миф. Разгон видеопамяти не имеет смысла

Конечно, наибольший прирост дает разгон ядра видеокарты — тут прирост производительности близок к линейному (то есть увеличили частоту на 10% — получили прирост производительности на 10%). Однако не стоит сбрасывать со счетов видеопамять, особенно в слабых видеокартах: зачастую в них ставят те же чипы памяти, что и в более мощные решения, но при этом сильно снижают частоту. Это дает возможность ее достаточно сильно разогнать, зачастую на 20-40%, что может прибавить к общей производительности графики еще 10-15% — для слабых видеокарт это лишним, разумеется, не будет:

Двенадцатый миф. С выходом каждой новой линейки видеокарт производители урезают производительность старой

Достаточно популярный миф, основанный обычно на том, что на одних (обычно более старых) версиях драйверов видеокарта работает лучше, чем на других (обычно более новых). Разумеется, никакого реального основания он не имеет: если бы Nvidia и AMD на самом деле хотели заставить пользователей обновить видеокарты, они бы прекращали их поддержку как производители смартфонов на Android, через пару лет после выхода. Однако на деле даже решения 600-ой линейки от Nvidia, вышедшей более 6 лет назад, до сих пор получают новые драйвера наравне с более новыми видеокартами, причем со всеми программными «плюшками» типа DirectX 12.

Но почему тогда есть разница в производительности между драйверами? Потому что ничто в нашем мире не идеально, и какие-то драйвера, улучшая производительность в новых играх, могут испортить производительность в более старых или привести к различным ошибкам. Обычно через некоторые время выходят исправленные драйвера, и все возвращается на круги своя.

Если вы знаете еще какие-либо мифы — делитесь ими в комментариях.

Сижу я такой и смотру спецификации память в видеокартах и вдруг подумал, почему видеопамять во время простоя не может дополнять ОЗУ, а когда включается игра тогда разгружаться, тем самым увеличивая производительность пк вне игр. Да я знаю что для мощного компа с 16/32 гб ОЗУ это почти ничего не даст, но например у меня 8гб и часто открыто много вкладок и программ, как вы можете понять у меня начинаются фризы из-за нехватки озу, но при этом в видеокарте простаивает 6гб более быстрой памяти. Немного поискав я не нашел никакой инфы, может я плохо искал или до этого никто не додумался?! Но мне кажется идея хорошая.

Дубликаты не найдены

Омг, откуда столько даунят в комментариях, которые даже не гуглят, прежде чем ответить?

По той статье всего 512 метров и работает через жопу ). Никому это просто не нужно.

Так это ж феррум-зависимая функция.

Ну и, хех, ситуации разные бывают. Одним днём™ мне приходилось запускать Android Studio на нетбуке с 1G рам. Мда.

Ну это частности. В любом случае эта ситуация из ряда вон =)

она быстрая для процесора видео карты

но для ЦП системного блока она медленая

Там высокопроизводительная память, юзать которую напрямую сложно. Можно, но сложно и тупо, вроде как микроскопом гвозди забивать.

Верно, приложения изъёбно работают с видеопамятью. А операционка предоставляет им достаточно простой доступ к ОЗУ.

@unrealCO , увы я не могу вам там ответить. Модератор сообщества решил что человек, который не понимает его точку зрения достоин бана сообщества 😀

Ничего удивительного. Вы отказываетесь поинмать реальные факты и пытаетесь всем доказать что ваши фантазии это и есть факты.

Гуть, ответьте на простой вопрос – все чемпионы одинаковые?

Если нет, то почему у большинства чемпионов вин рейт 50% +-5 ?

Ответ прост – т.к. берется статистика не чемпиона, а берется статистика команд.

PS это, кстати, не преступление – иметь свою точку зрения. Увы.

1) хз. Корректных вопросов там нет вообще, кроме "да ты ничего не понимаешь, го выйдем?".

2) всем как бы. Командная игра не означает свалку 5 на 5. Командная игра означает координацию действий.

3) я сравниваю чемпионов с РАВНЫМ эквипом по стоимости. Т.е. начиная от 2 минуты и выше.

Бонусный вопрос глуп однако. Все зависит от скиллов, времени и начального закупа. Чисто ради интереса – если взять сразу после старта, то победит уи. С 95% шансом. Потому что персонаж с турельками накопит первую турельку как раз к своей смерти 😀

@moderator , оскорбления комментом выше. А можно затереть оскорбление, не затирая пост? Прост у человека нервы слабые.

1) ну из последнего то хотя бы поясните про 5 секунд неуязвимости у тимо. А если почитать внимательно то там ещё очень много вопросов которые вы предпочли проигнорить. И в дальнейшем если вы будите соскакивать с тем и игнорить конкретные вопросы то я просто не вижу смысла продолжать дискуссию с вами.

2) Всё сказанное вами выше противоречит командной игре.

3) В том то и дело что yi очень зависит от закупа. Yi c 6 слотами по полезности полная противоположность yi с 1 слотом.

На протяжении всей дескусии вы очень много раз показывали отвратительное знание скилов и механик игры. Основываясь на ошибочных знаниях вы делаете ошибочные выводы и настаиваете что ваша точка зрения единственно верная. Вам уже много раз указывали в чём вы не правы но вы продолжаете настаивать на своём отрицая любую точку зрения кроме вашей. Для примера у хеймера 3 турелки сразу же как прокачаешь скилл. До 2 минуты он поставит 3 и ещё 3 накопит. А это говорит что факты говорят совершенно о противоположном в сравнении с тем что вы утверждаете. В прочем уже в который раз.

1) по поводу тимо – у него имборадость на "снижение меткости противника". Т.е. 60% игроков ничего с ним сделать не могут 🙂 Вкупе с невидимостью это даёт 5-6 секунд неуязвимости. Тупо нанести дамаг невозможно 🙂

2) что? Я вас не понимаю. Командная игра это не "эгей пошли все на мид". Командная игра это "Эгей, я на топе, ты в лесу, ты в джунглях, а я тут в засаде. И все помогают друг другу".

3) вы прям сказали умную вещь. Настолько умную и настолько простую, что данный постулат мною ВООБЩЕ не поднимался 🙂

PS отвратительное знание игры показываете вы. На счет того же уи. "Все работает, это не уяз, вот статью. А в конце статьи написано – всё прекрасно, это неуяз, вот уи."

PPS 3 турельки + хейм сколько? 4. Сколько целей поражает умение yi? 4. Дамага от умения уи хватит чтобы убить турельки? Однозначно. Так что это у вас что-то с математикой и знанием игры 😀

И снова вы показали ужасное знание игры и подтвердили все мои слова. Не судите по себе и не пишите бред. И описание скилов почитайте для начала. У турельки 150 пх на 1 уровне. Yi явно не сможет с 1 скила их положить. И даже если случиться какое то чудо и он их убьёт то хеймер поставит сразу ещё 3 новых. Если мне память не изменят там кд на них будет чуть более 1 секунды. Если вы и дальше планируете писать свои догадки и представлять их как факты я просто буду игнорировать вас.

PS

Просто хочу конкретно вас носом ткнуть. У тимо ослепление действует максимум 2,5 секунды. При этом ослепить вы можете только одну цель а любая другая будет вас всё также бить и магический урон проходит на все 100% даже под блиндом. А это уже очень не похоже на неуязвимость. Вы так описываете невидимость тимо как будто это какой то активный скилл который вы можете включить в любой момент игры. Но ведь это не так. И если вы даже это не знаете то очевидно что ваше знание о игре гораздо ниже уровня начинающего игрока.

Мдя. Память вам изменяет. Советую срочно найти любовника и убить его.

Я ему про бога, он мне про козла. Я ему про 1 на 1, он мне про 2 на 1. Я ему 1 на 1, он мне 5 на 1. Вы вообще понимаете значение слов "имба сильнее любого чемпиона не имбы 1 на 1"? 🙂

PS с каждым следующим вашим глупым комментарием ваш предполагаемый возраст всё уменьшается и уменьшается 🙂 В моих глазах.

2,5 сек а не 5-6 + магический урон проходит + инвиз не активный скил. Про 1 на 1 я вам выше написал. Все мои замечания опять проигнорили. Следующее сообщение прошу написать мне только тогда когда вам исполнится как минимум 8 или когда хотя бы серебро возьмёте.

Вай вай. Обидел человека, что ж вы за зверь такой. Как мне теперь в обратную сторону стареть, хотя в рейтинге опуститься и мог бы, если б играл 🙂

Просто коротко резюмирую.

1) Скилов и чемпионов в не знаете. Вместо этого сами придумываете скилы и пытаетесь этой информацией убеждать других более понимающих игроков. Со стороны это даже не смешно. Все кто прочитал нашу переписку смотрят на вас с недоумением (в лучшем случае)

2) По вашему мнению имба это чемпион который будет сильнее всех остальных при равном закупе. Но при этом я привёл несколько примеров в которых даже самый слабый чемпион (по вашему мнению) выигрывает у вашего самого сильного. Так что же имба совсем не имба получается? Или вы переобуваетесь по ходу дискуссии в каждом новом посте?

3) Игнорируете когда вам указывают на то в чём вы не правы и переводите темы. Прям как любой школьник начальных классов.

4) У вас очень большие проблемы с логикой

5) В чём их этого я не прав?

1) парень, я ни в одном из скиллов не ошибся. Ни в одном из комментариев. Ни в одном из произведенных эффектов. Это тяжело признавать, но вы принимаете желаемое за действительное.

2) эээ. Где вы привели примеры? Вы привели размытые какие то фразы вроде "один на один на первом уровне". Я могу сходу 2-3 варианта тактики накидать при этом, но ни в одном из этих вариантов хейм не победит уи в опять таки равных условиях. И даже голый не победит. А персонажи, которые имеют высокий дамаг и оглушение одновременно, с вероятностью в 95% имбы. И это еще одно упущение риотов, но эт просто к слову.

3) ? Я тему ни разу не перевел. Я все об одном и том же. Об одной игре, об одном чемпионе, об одной ситуации, об одних характеристиках. И ни шагу не ступил назад.

4) отнюдь. Моя работа зиждется на логике, её отсутствие бы привело к моему профессиональному нищенству.

5) альфа страйк уи или же первый удар является умением, во время которого на уи не действуют никакие доты/скилы замедленного действия/руты/урон по области/урон по чемпионам/магия/эффекты местности. И это написано в статье что вы привели. К сожалению вы просто не долистали статью до конца.

Я не отказываюсь вести диалог, но это довольно сложно. Потому что вы каждый раз будто забываете свои предыдущие высказывания 🙂

Несмотря на то, что современный контент требует все более мощных графических ускорителей, некоторые задачи вполне по силам интегрированным в процессор или материнскую плату видеоядрам. Встроенная графика не имеет собственной видеопамяти, поэтому пользуется частью ОЗУ.

Из этой статьи мы узнаем, как увеличить объем памяти, выделяемой интегрированной видеокарте.

Увеличиваем память видеокарты

Первым делом стоит заметить, что если Вы ищете информацию о том, как добавить видеопамяти дискретному графическому адаптеру, то спешим Вас разочаровать: это невозможно. Все видеокарты, которые подключаются к материнской плате, имеют собственные чипы памяти и только иногда, когда они переполняются, «перекидывают» часть информации в ОЗУ. Объем чипов фиксированный и коррекции не подлежит.

В свою очередь, встроенные карты используют так называемую Shared memory, то есть ту, которой система с ней «делится». Размер выделенного места в оперативке определяется типом чипа и материнской платы, а также настройками БИОС.

Прежде, чем пытаться увеличить количество выделенной памяти для видеоядра, необходимо выяснить, какой максимальный объем поддерживает чип. Посмотрим, какого типа встроенное ядро стоит у нас в системе.

-

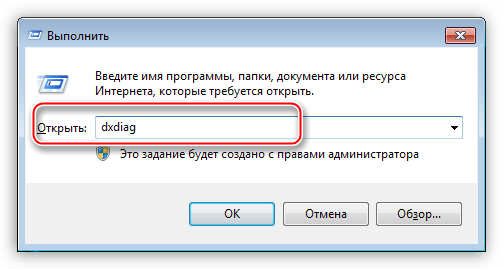

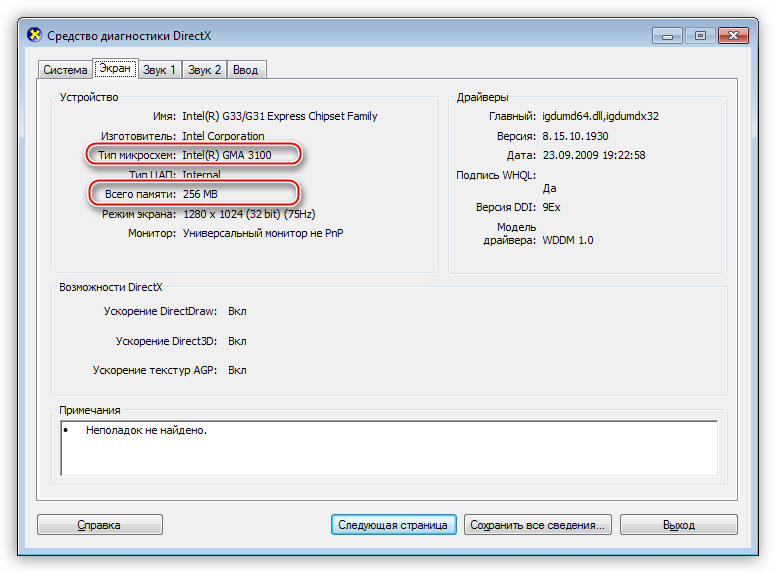

Нажимаем сочетание клавиш WIN+R и в поле ввода окна «Выполнить» пишем команду dxdiag.

Откроется панель диагностики DirectX, где нужно перейти на вкладку «Экран». Здесь мы видим всю необходимую информацию: модель графического процессора и объем видеопамяти.

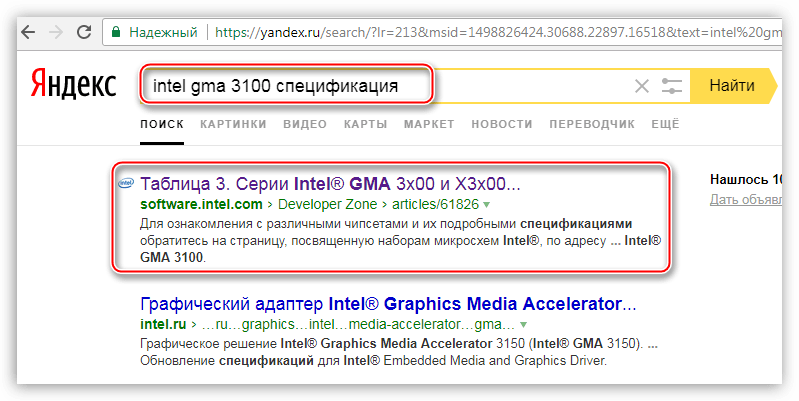

Поскольку не обо всех видеочипах, особенно старых, можно легко отыскать информацию на официальных сайтах, то воспользуемся поисковой системой. Вводим запрос вида «intel gma 3100 характеристики» или «intel gma 3100 спецификация».

Видим, что в данном случае ядро пользуется максимальным количеством памяти. Это значит, что никакие манипуляции не помогут увеличить его производительность. Существуют кастомные драйвера, которые добавляют некоторые свойства таким видеоядрам, например, поддержку более новых версий DirectX, шейдеров, увеличенных частот и прочего. Использование такого ПО крайне не рекомендуется, так как может вызвать неполадки в работе и даже вывести из строя Вашу встроенную графику.

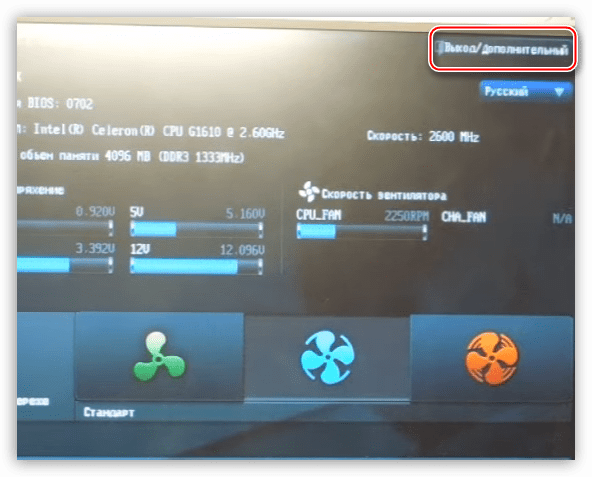

Идем дальше. Если «Средство диагностики DirectX» показывает объем памяти, отличный от максимального, то существует возможность, изменив настройки БИОС, добавить размер выделенного места в ОЗУ. Доступ к настройкам материнской платы можно получить при загрузке системы. Во время появления логотипа производителя необходимо несколько раз нажать на клавишу DELETE. Если этот вариант не сработал, то почитайте мануал к материнке, возможно, в вашем случае используется другая кнопка или комбинация.

Поскольку BIOS на разных материнских платах могут сильно отличаться друг от друга, то точной инструкции по настройке привести невозможно, только общие рекомендации.

Для БИОСов типа AMI нужно перейти на вкладку c названием «Advanced» с возможными дописками, например, «Advanced BIOS Features» и найти там пункт, где имеется возможность выбрать значение, определяющее объем памяти. В нашем случае это «UMA Frame Buffer Size». Здесь просто выбираем нужный размер и сохраняем настройки клавишей F10.

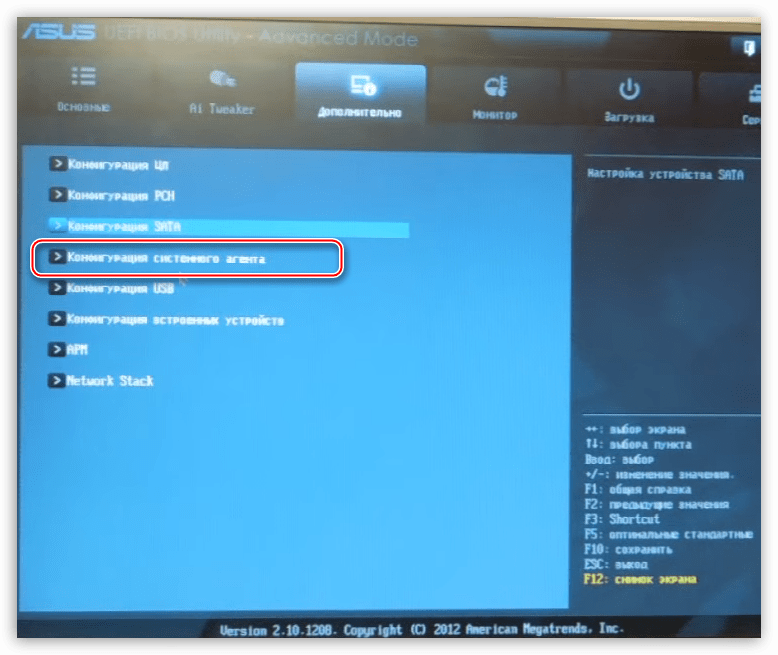

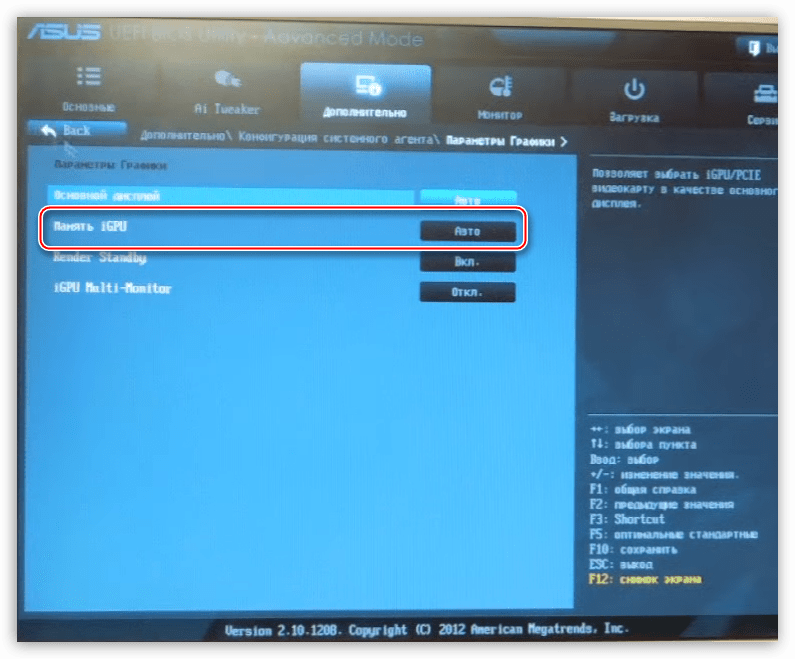

В UEFI БИОСах необходимо вначале включить расширенный режим. Рассмотрим пример с BIOS материнской платы ASUS.

-

Здесь также нужно перейти на вкладку «Дополнительно» и выбрать раздел «Конфигурация системного агента».

Далее ищем пункт «Параметры графики».

Напротив параметра «Память iGPU» меняем значение на нужное.

Использование встроенного графического ядра несет в себе пониженную производительность в играх и приложениях, которые используют видеокарту. Вместе с тем, если для повседневных задач не требуется мощь дискретного адаптера, то встроенное видеоядро вполне может стать бесплатной альтернативой последнему.

Не стоит требовать от интегрированной графики невозможного и пытаться «разогнать» ее при помощи драйверов и другого программного обеспечения. Помните, что нештатные режимы работы могут привести к неработоспособности чипа или других компонентов на материнской плате.

Отблагодарите автора, поделитесь статьей в социальных сетях.