Содержание

Отрицательные отзывы

Греется просто жесть. Этот чудо вентилятор не справляется. Шумная. Покупалась в современные игры играть а не кино смотреть.

Пришлось разобрать системный корпус, поставить кустарно доп вентилятор, после установки по с официального сайта перестала обновятся винда 10 (постоянно пишет ошибку обновлений-живу теперь так). Через пол года вентилятор начал гудеть на средних оборотах.

- производительность. как вы понимаете, производительность зависит от чипсета и стоимости и не может являться достоинством. За эту производительность клиент платит +- 23 тр. и она почти идентична у разных производителей с один и тем же чипсетом и характеристиками памяти. Иными словами любая другая карта gtx 970 4gb будет аналогично тянуть всё современное на ультре.

- Второй "плюс", подсмотрел в чужих комментариях – это то, что система охлаждения выкидывает теплый воздух за пределы корпуса. Для меня это не плюс, потому как корпус открыт и мне все равно куда СО выкидывает теплый воздух, но, возможно, кому-то это действительно нужно.

- система охлаждения. 77 градусов при 100% нагрузке (гта 5). слышали как звучит истребитель второй мировой? это не просто гул, а характерный стрекот цилиндров в двигателе. в простое температура 30-35. гул конечно ниже чем при 100% нагрузке, но тоже явный (из-за него и сдал). про какой либо разгон с данной СО молчу. а менять СО – слетать с 3-х летней гарантии.

До покупки этой карты я не понимал людей, которые жалуются на шум системного блока. теперь понял 2. основная причина моего негодования, конечно субъективна: покупая карту за 23 тр я не хочу читать отзывы выискивая недочеты. я наивно полагал и верил асусу, что поставлю карту и буду наслаждаться. а выходит так, что с т. з. маркетинга необходимо создать "дешевый вариант" и за 23 тр клиент приобретает заведомо и осознанно изготовленный товар низкого качества (! ) (шумная СО которая допускает разогрев карты до 77 гр). хочешь тише – покупай стрикс за 25. да и купил бы, если б знал, мне не жалко 2 тр! 3. еще ирония в том, что я играю в наушниках и не слышу ее гул под нагрузкой. гул же меня беспокоит при работе на компьютере без наушников, когда карта находится в простое! * до покупки этой карты АСУС был эталоном для меня. я без раздумий покупал сам и рекомендовал своим друзьям, чего теперь, конечно, делать не буду. * в манибэк карту не сдать – прикрутил ее винтиком к корпусу, тот оставил след, наивно полагал что прикручиваю надолго (не прикручивайте карты пока не убедитесь, что сдавать не будете! ). отдал в СЦ на диагностику.

Нейтральные отзывы

Пользователь скрыл свои данные

При минимальных оборотах появляется низкочастотный гул, исчезающий почти полностью только когда уже шум гоняемого по корпусу воздуха становится существенным. по итогу лучше держать вентилятор где то на 35%, но и в этом положении он на порядок шумнее всех остальных 6 вентиляторов (2 noctua на процессоре, zalman и arctic чето там сзади-спереди и 2 узких skythe на боку) в моем корпусе. Сейчас бы купил другую модель с обычным вентилятором.

Сама по себе хороша, но есть проблема с охлаждением, сразу после её покупки пришлось купить ещё кучу охлаждения.

Покупал год назад, впечатление так себе, меняли 2 раза, из-за отвала чипа и дико грелась и потом очень сильно шумела.

- Отличная производительность за свои деньги, пока не вышла 1060.

- Система охлаждения достаточно тихая на низких оборотах.

- Температуры у меня обычно не превышали 74 градусов при 100% нагрузке видеокарты.

- Размеры, и даже не размеры а расположение системы охлаждения, которая несколько смещена вверх и вправо, если смотреть прямо на вентиляторы. Из-за этого карта занимает больше места, чем могла бы.

- Нет бэкплейта, а он тут очень бы пригодился – моя видеокарта заметно провисла под собственным весом, немного изменив форму платы.

Если цена упадет чуть ниже GTX 1060 на 6GB или хотя бы будет примерно схожей, то брать определённо стоит.

- Производительность

- GTA V (не онлайн) в Full HD на абсолютно всех максимальных настройках 90-120 фпс (с процессором i5-4460)

- Цена

- Очень сильно греется, может мне такая попалась – не знаю, при стандартных оборотах кулера в GTA V греется аж до 80-85 градусов

Приходится программно ставить обороты кулера на 80-100%, тогда температура держится в районе 55-65 градусов

Высокая производительность в вышедших играх, разница с HD7970 небо и земля. Большинство игр идут на 60FPS+.

- Адский перегрев текстолита в районе VRM (системы питания), MSI на питальнике сильно сэкономила (всего 3 фазы питает GPU) из-за чего зона VRM перегревается почти до 90С, при этом сам GPU может быть холодным 62-65С.

- Очень не обрадовала производительность в STALKER: LOST ALPHA, с включенной ТЕНЬ ОТ ТРАВЫ, опять просадки до 40фпс, карта постоянно на 100% загружена.

Больше всего огорчил перегрев питальника, всякие не умные «кричат»: «Тихая. Холодная», измеряя тем-ру GPU в программах, типа GPU-z, полностью игнорируют сильнейший перегрев зоны VRM, рано или поздно, оно может проявятся выгоранием и огромных проблем с гарантией, когда деньги можно будет вернуть только через суд.

Положительные отзывы

Вчера купил сие четырёхгигабайтное чудо для того, чтобы на максимальных настройках поиграть в новейшие игры: Assassin’s Creed : Unity, Far Cry 4, GTA 5, Witcher 3. также хотелось посмотреть на производительность в Crysis 3 и Watch Dogs.

За неимением 4к монитора приходится пока играть в Full HD, но судя по запасам мощности, 4K в современных играх для неё не проблема. Не понимаю, зачем тратиться на более дорогую GTX980? Наверное, если ещё и в 3Д играть.

Так вот, сразу вчера прогнал тестами установленные Крайзис 3 и Вотч Догс. Был не то, что приятно удивлён, а просто ошеломлён! Судите сами: Крайзис 3 при ультра настройках выдал мне средний FPS в 50 кадров, и это без разгона. То есть, в Ultra HD средний ФПС будет порядка 25, а при разгоне все 30-35, чего вполне достаточно для комфортной игры, ИМХО. Для сравнения, моя предыдущая R9270x в Фулл ХД выдавала в 2 раза меньше, то есть всего 25.

Что касается Вотч Догс, то там количество кадров в секунду вообще уходит за 60! Абсолютно та же ситуация и с Assassin’ом новым.

Сегодня качаю в СТИМе Фар Край 4, вечером добавлю комментарий о том, что там покажет карточка.

Думаю, что для Ведьмака 3 хватит её, а для ГТА5 уверен на 100%, что с головой. В общем, всем советую 😉

PS Тестирование проводилось при участии процессора i5 4670K с 16 Gb ОЗУ.

Dying Light на всех возможных ультра настройках, в открытом мире выдаёт красивую графику и при этом кушает 2, 6 ГБ видеопамяти, в Call of Duty: Advanced Warfare где нету открытого мира по умолчанию кушает 3, 7 ГБ видеопамяти причём это на выключенных пост обработках. Включив пост обработку, слетают текстуры до низкого разрешения ( проблема в драйверах? проблема видюхи мало видеопамяти ? проблема с оптимизации в игре?). Также много кушает память Watch Dogs.. ну и сказать что для данной видеокарты мало памяти я не могу .. Видюха поддерживает дайрэкс 12 (DirectX 12) а он будет менее требовательным к железу и думаю что 4 ГБ видеопамяти должно хватать( за исключение 4к гейминга) разработчикам игры надо оптимизировать. В полне доволен данным девайсом.

Обновлял свой старый компьютер частями.

Год назад мне посчастливилось купить эту замечательную видеокарту, но мой процессор сказал мне «Нет, дружище! Я такое не потяну! ».

Пришлось копить на современный процессор, который раскроет это чудо. И вот этот день настал!

Производительность выше крыши! Дизайн с подсветкой также сильно удивил меня (раньше с таким не сталкивался)

Тянет многие современные игры на запредельных настройках и стабильно выдает 60 фпс. коллективно с процессором (INTEL Core i5 4460). Полностью доволен покупкой!

Моему старому компьютеру остается только завидовать такой красоте : )

Приобрел карточку 20 февраля 15 года, на замену радеону r9 270x, разница довольно ощутимая.

Стоит в связке с i5 3470 погнанном до 3. 6 ггц и 8 гб рам, — почти везде 60 фпс кроме некоторых игр.

Тут вообще конечно от конкретного приложения все зависит, но как ниже уже писали новый дум, дакр солс 3, гта 5, 3 ведьмак идут спокойно на ультрах в 1080p в 60 кадров/сек — бывают правда просадки небольшие, но это скорее недоработки игровых приложений, все таки сегодня принято на тяп ляп делать игры.

И даже несмотря что нвидиа наврала с характеристиками и по сути у карты лишь 3. 5 гига памяти, а остальные 512 мб работают на меньшей скорости, а также вместо 64 блоков роп всего 56, карточка все равно неплохая — почти везде 60 кадров.

Как по мне так это лучшая видеокарта для геймера. GTX 970 обладает отличной производительностью, за свои деньги. Игры на ней идут на ультра настройках без всяких проблем (при разрешении 1920X1080), а 4Gb память позволяют выставлять текстуры самого высокого разрешения. Температура видеокарты при стресс-тестах в специальных программах, таких как FurMark, не превышала 70°C. При этом кулера видеокарты работали очень тихо и почти не заметно. Также видеокарта поддерживает новый DirectX 12 и Nvidia PhysX, что сделает игры на ней ещё более красивыми чем на её конкурентах.

В заключении, хотелось бы сказать, что если вы собираете компьютер для игр, то эта видеокарта для вас.

Я люблю поиграть в игры, всегда по возможности обновляю свой комп, даже если производительности мне хватит еще на пару лет. Сидя в ожидании новой линейки видеокарт, я наконец дождался этого момента и решил купить GTX 970. До этого стояла GTX 780, так что есть, с чем сравнивать. Как и прежде, все игры идут на ультра настройках, видеокарта слабо греется – не более 72 градусов под нагрузкой, шумом не выделяется. Большой разгонный потенциал. Легко разгоняется до 1350/1400 mhz по ядру и почти до 8000 по памяти. Большой запас памяти. Целых 4gb. Из недостатков можно отметить слегка завышенную цену, покупал за 18100. Сбросить на пару – тройку тысяч и тогда конкуренты у неё вряд ли появятся. В целом – отличная видеокарта, всем доволен, кроме цены, разумеется.

Хочу поделиться впечатлениями от эксплуатации карточки GeForce GTX 970 от ASUS (версия с турбиной). Данную карту покупала на замену модели RADEON R9 290x от PowerCool тоже, кстати говоря, с аналогичной системой охлаждения. Явным преимуществом устройства от ASUS, помимо того, что она немного мощнее, являются ее температурные режимы. R9 290x грелась безумно, при включении современной игрушки буквально через 10-15 минут рабочая температура приближалась к 90С, а это уже близко к ее максимальным значениям. GTX 970 от ASUS же еще не разу не превышала порог в 61 градус, хотя эксплуатирую ее нещадно. К тому же целый букет из стандартных положительных моментов, такие как отсутствие проблем с совместимостью, красивый дизайн (карта выполнена в элегантном бело-красном корпусе), комплектность и упаковка (упаковка реально радует, такое впечатление, что открываешь швейцарские часы)).

- хотелось бы отметить шум турбины при максимальной загрузке процессора карты, хотя для меня это не критично – играю в наушниках.

Очередь просмотра

Очередь

- Удалить все

- Отключить

YouTube Premium

Хотите сохраните это видео?

- Пожаловаться

Пожаловаться на видео?

Выполните вход, чтобы сообщить о неприемлемом контенте.

Понравилось?

Не понравилось?

Текст видео

Цена, отзывы и характеристики:

✔ #ASUS GTX970 4096Mb (STRIX-GTX970-DC2OC-4GD5)

— https://f.ua/asus/pci-e-geforce-gtx97.

➔ Смотри наши обзоры, чтобы БОЛЬШЕ узнать о компьютерной технике:

✔ ЖМИ — https://www.youtube.com/playlist?list.

Новая #видеокарта GTX1070 просто отлична! Однако 970 всё ещё актуальна, особенно учитывая, что 1070 первое время будет стоить дорого, а 970-я опускается в цене. Если есть цель купить видеокарту до 10 000 грн с максимумом возможностей, то именно ASUS #Strix — отличный вариант. И вот почему: в обзоре)))

Тайм-код:

0:16 – Чем хороша эта видеокарта?

1:35 – Треск дросселей #видеокарты ASUS Strix GTX970 DC2OC

2:16 – Особенность системы охлаждения

2:44 – Система охлаждения

4:00 – Сравнение размеров и охлаждения с GTX 960

4:16 – Тестирование в играх

6:15 – Короткие итоги обзора

Всем привет! Это третья, заключительная часть материала о производительности видеокарты NVIDIA GTX 970. В первой части мы говорили о поколениях видеочипов, внутреннем устройстве GTX 970 и причинах шума на тему трёх с половиной гигов, во второй — изучали, насколько это виляет на производительность и что намерили всякие железячные издания, а сегодня займёмся непосредственно испытаниями и посмотрим, в чём GTX 970 хороша, а в чём — не очень.

Тестовое оборудование

Для тестов я использовал свой личный ПК: Core i7-3930K (6 ядер @ 4.2 ГГц), 16 гигабайт достаточно редкой памяти Kingston HyperX Beast 2400 МГц в четырёхканальном режиме (быстрее на DDR3 сложно что-либо найти), все игрушки и бенчмарки стояли на PCI-Express SSD диске, чтобы минимизировать влияние остальных компонентов на результаты тестов). Всё это дело подключено к монитору с разрешением 2560х1440 точек. Как видите, упираться особо не во что: игрушек с 64 битной архитектурой и бинарниками — кот наплакал, а остальным, по идее, должно всего хватать. Разумеется, все обновления, патчи, драйвера, хотфиксы и всё такое стояло самое свежее, прямо с грядки.

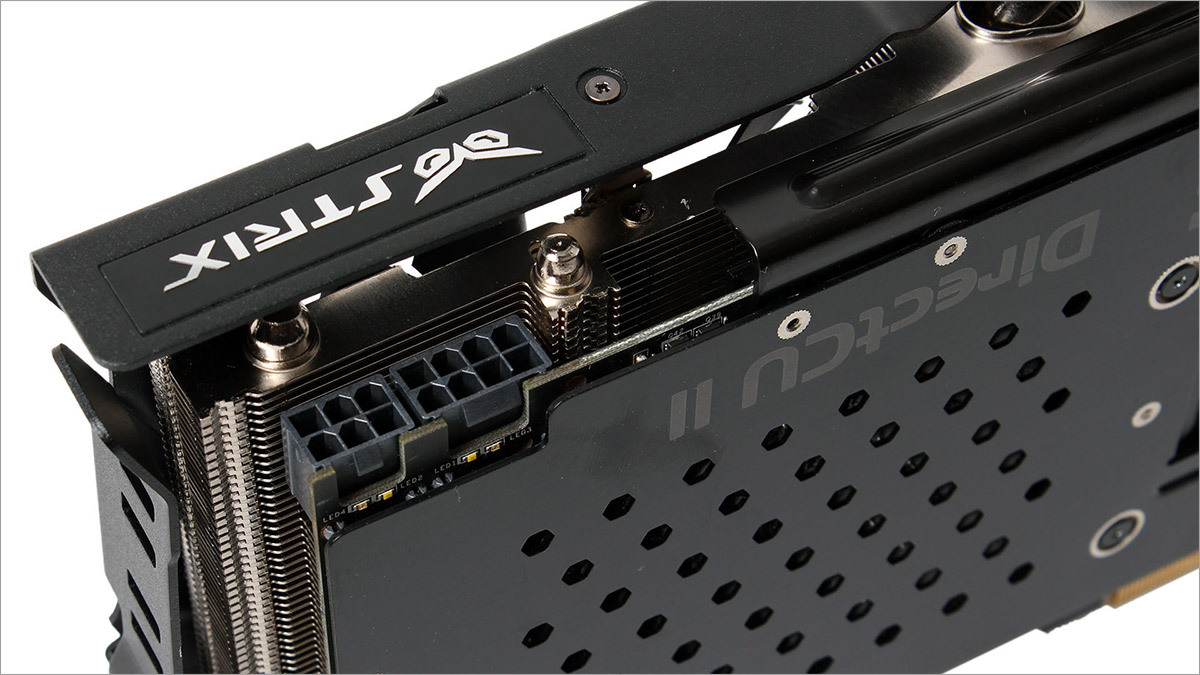

В качестве подопытного я использовал ASUS STRIX GTX 970: видеокарту с потрясающе тихой системой охлаждения и отличным железом.

На чём тестируем?

Во что там у нас нынче молодёжь играет? А то я слышал, что Battle City из моды немного вышел… В общем, для теста выбраны следующие игры:

- Batman: Arkham origins

- Battlefield 4

- Bioshock Infinite

- Company of Heroes 2

- Crysis 3

- Diablo 3

- Far Cry 3

- Far Cry 4

- Metro: Last Light

- Tomb Raider (2013)

Во всех случаях будут применяться максимально возможные настройки графики с отключённой вертикальной синхронизацией и активным сглаживанием х4. Всякие Frame Limiter’ы и прочие «сглаживатели» были выключены, после каждого теста видеокарта остывала до нормальных температур а система перезагружалась.

Специальный гость — игра, которые не отличаются фантастической графикой или оптимизацией, но может задать жару многим GPU при определённых условиях. Нам она нужна чтобы показать некоторые узкие места архитектуры Maxwell. Использовать будем Dark Souls 2 и выполнять downscale с разрешения 3840×1260 до 2560×1440 и с 5220х2880 до 2560×1440.

К сожалению, GTA V на момент проведения тестов и написания статьи ещё не скачалась вышла, а после уже не было времени на восстановление тестового окружения, так что простите, в этот раз без неё.

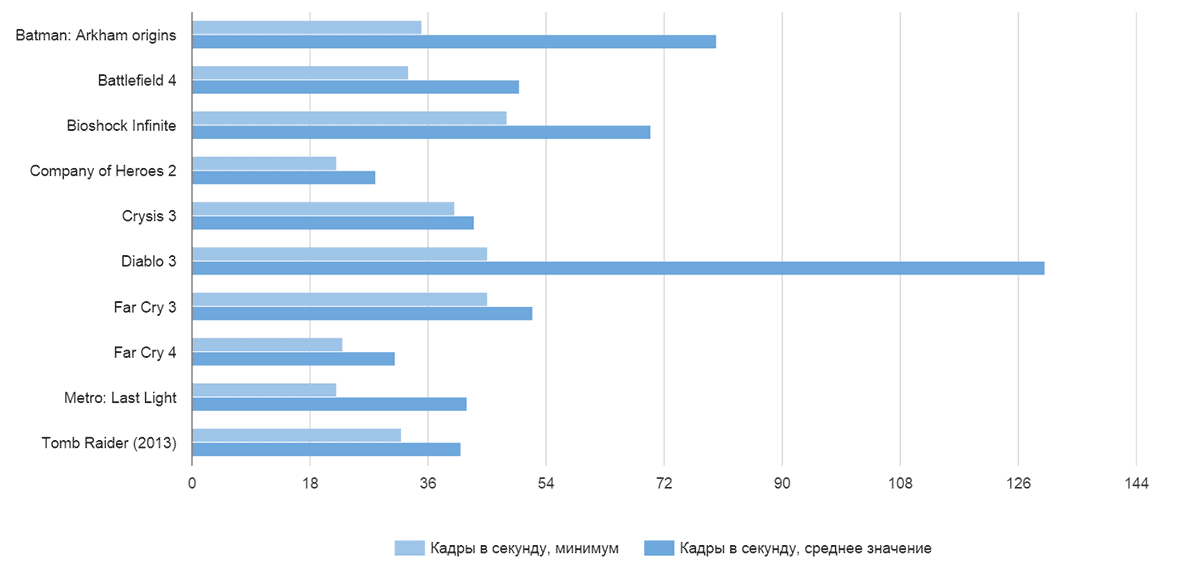

Результаты тестирования

Для разрешения 2560х1440 достичь достаточно производительности достаточно сложно. Не так давно (в топике про GTA V) я нашёл человека, для котого «ниже 60 FPS — безумные лаги). Что ж, у каждого вкусы свои, но я считаю, что 30 FPS на таком разрешении с одной видеокартой — вполне играбельный вариант, особенно если в напряжённых сценах количество кадров в секунду не проседает ниже 25. Вот результаты:

Как видите, почти все игры на супер-настройках и с четырёхкратным сглаживанием показывают приемлемые результаты, за исключением откровенно прожорливых монстров с так себе оптимизацией: Metro Last Light и Company of Heroes 2 ожидаемо стали аутсайдерами чартов.

Что касается потребления памяти, то «выйти» за трёх с половиной гигабайтовый рубеж удалось только в Battlefield 4 и Far Cry 4, (видимо, магия цифры 4, не иначе). Crysis и Metro даже близко не подошли: самые сложные сцены с трудом занимали 3.2 ГБ видеопамяти.

Maxwell бонусы

Помните самый первый пост про GTX 970? Там мы рассматривали все пост-DX9 видеокарты NVIDIA и отметили, что вот уже три поколения как компания бьётся над энергоэффективностью своих чипов. С одной стороны — дело благородное, с другой — на десктопах особо потреблением можно не запариваться: чай, не от батарейки работаем. С другой — если уменьшить энергопотребление и тепловыделение, то в рамках того же теплопакета можно будет выжать больше производительности. И именно в этом Maxwell превзошёл как прошлые поколения, так и красно-белых конкурентов.

Дело в том, что энергоэффективные чипы GM-204 имеют теплопакет 165 Ватт. А ещё имеют технологию автоматического разгона: пока температура позволяет, а нагрузка — соответствует, частота ядра повышается в определённых разумных пределах. Соответственно, чем надёжнее цепи питания, лучше охлаждение, выше базовая частота чипа и памяти — тем больших результатов может достичь видеокарта на архитектуре Maxwell под нагрузкой: тем самым уменьшая просадки в FPS и увеличивая средний frame rate. Эдакий аналог Intel’овского Turbo Boost.

Штатные частоты моей видеокарты составляли:

Ядро, Normal — 1114 МГц

Ядро, Boost — 1253 МГц

Память: 7010 (1752.5 х4) МГц

После некоторого шаманства с софтовым поднятием напряжения, проверкой на стабильность и прочих ухищрений удалось получить следующие результаты:

Ядро, Normal: 1333 МГц

Ядро, Boost: 1490 МГц

Память: 8000 (2000 х4) МГц

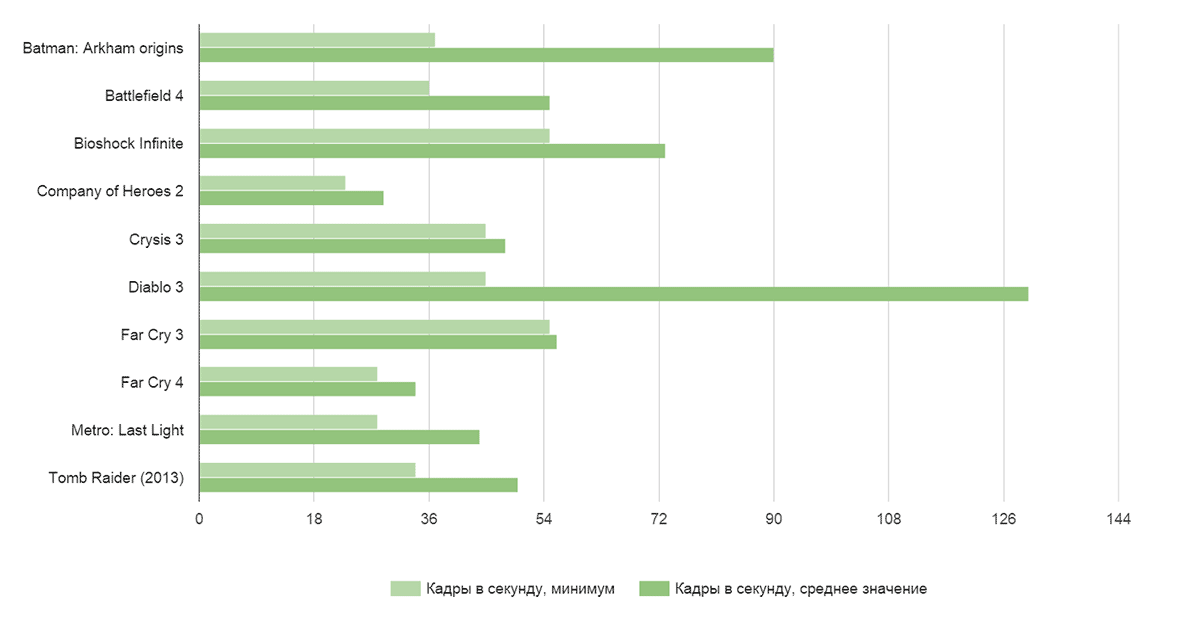

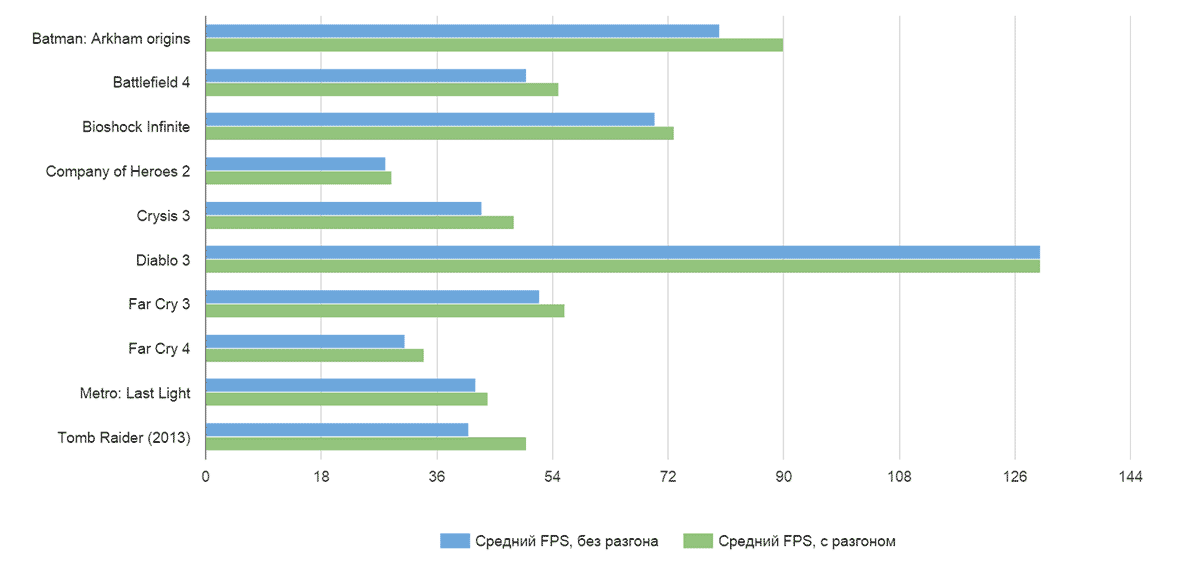

Как это сказалось на производительности? Самым лучшим образом:

Почти везде графики перевалили за рубеж «комфортных» 25 FPS. Забавно, но разгон совершенно не сказался на производительности Diablo 3: видимо, либо какой-то внутренний лимитер всё же действует, либо игра упирается во что-то другое. А кривую Company of Heroes 2 даже разгон не спас, как были унылые результаты, так и остались.

Вот сравнение минимальной частоты кадров:

Здесь прирост наиболее важен и заметен: в самый напряжённых сценах исчезли микрофризы и подлагивания, в целом картинка стала плавнее.

Средняя частота кадров тоже подросла, но не так сильно, и в целом прирост производительности, скорее, характерен для очень нагруженных сцен, чем для общей динамики:

А теперь самое главное. Что с разгоном, что без — видеокарта удивительно тихая. Нет, конечно, через час-другой игры в Crysis 3 с такими настройками будет некоторый фоновый шум, но ни в какое сравнение не идёт с шумом и нагревом монстров прошлого поколения типа AMD HD7970, GTX 780 и уж тем более воем референсных турбин. В этом плане ASUS молодцы и сделали отличную систему, которая не шумит и выполняет свою работу на пять с плюсом.

Личное мнение

В прошлом посте отдельно жаловались на Far Cry 4, мол, если игра всё же выползает за 3.5 ГБ, то начинаются всякие микрофризы, лаги, выпадения кадров, а на записи и вообще кошмар творится (вторая половина ролика):

В игре такой красоты с выпавшими кадрами и размазанными цветными пятнами вы не увидите, просто будет незначительная потеря плавности картинки. В том же Crysis 3, если его удаётся вывести за пределы потребления 3.5 ГБ видеопамяти вообще таких проблем не наблюдается и просадка производительности практически не видна, особенно если смотреть в прицел и наслаждаться геймплеем, а не пялиться в FPS-метр, ловить кратковременное падение производительности, делать скриншот и бежать на форум, жаловаться на то, какая NVIDIA плохая. 🙂

Для разрешения 2560х1440 и 2560х1600 видеокарты хватает во всех играх: если, конечно, вас устраивает средний показатель в 30-40 FPS. Само собой, для 4K2K видеокарты не хватает, и дело здесь не в памяти, а в самих вычислительных возможностях видеоядра. В качестве 4К2К теста я использовал Dark Souls 2 с патчем на даунскейл графики. Сам по себе Dark Souls не блещет ни графикой, ни системными требованиями. На средне-высоких настройках можно спокойно играть в FullHD разрешении с мобильной видеокартой GT650M и 1 ГБ видеопамяти. Основная нагрузка в данном случае ложится на GPU, а не на видеопамять: так как никаких супер-сложных спецэффектов не применяется, постобработка достаточно примитивная, а сама игра разрабатывалась с учётом возможностей консолей прошлого поколения (для тестов использовалась первая версия, без Scholar of the First Sin). С даунскейлом 3840х2160 до 2560х1440 NVIDIA GTX 970 выдаёт уверенных 15-18 FPS, с разгоном — 16-19. То же упражнение, но с разрешением 5120х2880 вовсе приводит к удручающим 12-14 FPS.

Для сравнения, старый AMD HD7970 с 3 ГБ видеопамяти и работающий с небольшим разгоном (1024 МГц ядро, 5600 (1400х4) МГц память) уверенно выдаёт 25-30 FPS для разрешения 3840х2160 точек и 20-22 FPS для 5120х2880.

Почему так происходит

Во-первых, архитектура видеоускорителей AMD и NVIDIA сильно отличается как с точки зрения «общей философии», так и в некоторых частных подходах.

Видеокарта GeForce GTX 970 имеет базовую частоту ядра 1050 МГц и 4 гигабайта памяти GDDR5, работающую на частоте 1750х4 МГц, подключённую по 256-битной шине, разбитой на 8 сегментов по 32 бита каждый. Общий блок в 3.5 ГБ подключён через 224-битный сегмент, дополнительные 512 МБ подключены через 32-битный сегмент, что и является причиной замедления работы видеокарты, когда приложения вылезают за пределы 3.5 ГБ видеопамяти.

Ядро видеокарты Radeon R9 280X, работает на частоте в 1000 МГц и использует память 1500х4 МГц, подключённую по 384-битной шине. Она хоть и разделена на 6 двухканальных 64-битных блоков, но ни один из них не отключён, так что вся память доступна на полной скорости, пусть её и всего 3 ГБ.

Напрямую сравнивать характеристики (например, число TMU — texture mapping units) нет смысла: различная архитектура, частота работы и прочие особенности не могут наглядно отобразить превосходство той или иной видеокарты. Если приводить абстрактную аналогию: что больше займёт места — 20 ящиков какого-то неизвестного объёма или 30 ящиков немного другого? Только измерив объёмы и умножив на число ящиков мы можем точно ответить на данный вопрос.

Так что для актуального сравнения видеокарт лучше подставим показатели производительности R9 280X (она же 7970 1GHZ Edition) и GTX 970: они уже приведены к общему знаменателю и имеют одинаковую размерность. В обоих случаях будем сравнивать референсные значения стандартных ускорителей, а не разогнанных экземпляров различных вендоров.

| R9 280X | GTX 970 | |

| Производительность GPU, ГФЛОПС: | 3, 482 | 3, 494 |

| Пропускная способность памяти, МБ/сек.: | 288 000 | 224 000 |

| Скорость заполнения | ||

| пиксельная, МП/сек.: | 27 200 | 58 800 |

| текстурная, МТекс./сек.: | 108 800 | 109 200 |

Как видите, основное отличие производительности в области пиксельной скорости заполнения. Она отвечает за превращение полученных вычислений в готовый кадр: чем выше пиксельная скорость заполнения (pixel fill rate), тем, по идее, быстрее видеокарта может превращать «магию» в двухмерные картинки, которые можно отправлять монитор. Было бы что отправлять, и в этом кроется весь секрет. Если мы запускаем игрушку на невысоком разрешении, скажем, 1280х800, нагрузка на память и вычислительные ядра не высока: количество готовых кадров зашкаливает и видеокарта, допустим, может выдавать 100 или даже 200 FPS в простых сценах, если сможет превратить всё то, что она насчитала в двухмерную картинку и отправить её на монитор.

Если же мы запускаем игры в высоком разрешении, то каждый кадр становится намного сложнее в расчётах, кадровая частота снижается, а на ROP’ы (модули видеокарты, которые отвечают за перевод картинки в плоский кадр) ложится дополнительная нагрузка: есть разница, считать 1280х720=921 600 точек или 2560х1440=3 686 400 точек. Частота вывода готовых кадров падает, но падение производительности на всех предыдущих этапах сильнее, чем дополнительные потери на ROP’ах, и поэтому на невысоких разрешениях большие показатели pixel fill rate дают огромный прирост к результатам бенчмарков, а на всяких SuperUltraHD и 4K2K игры упираются в производительность самой видеокарты, а не выводящих картинку модулей, и результаты выравниваются.

Видеокарта от AMD отличается более высокой пропускной способностью памяти (показатели отличаются почти на 30%) и меньшим её объёмом (3 ГБ против 3.5+0.5 у GTX 970), сравнимой производительностью ядра, чуть большим количеством шейдерных процессоров. Именно здесь красно-белые и выиграли у чёрно-зелёных: производительности ROP’ов оказалось достаточно, а вот бонусы в лице высокой пропускной способности памяти и большем количестве вычислительных блоков сделали свою работу: при штатных частотах и высокой нагрузке HD 7970 или R9 280X смогла обогнать GTX 970. С поправкой на то, что игра не требовала больше 3 ГБ видеопамяти. Правда, цена этого превосходства — чудовищное энергопотребление Radeon’ов, и, как следствие, высокий нагрев, не самый приятный акустический режим работы и так себе разгон.

Итоги

GTX 970 — отличная видеокарта, которая позволит вам играть пару-тройку лет на высоких настройках во что угодно. Ущербной её назвать язык не поворачивается. 4К2К мониторов пока мало, оптимизация под них так себе, игровые движки развиваются… В общем, через несколько лет будет польза от всех этих нововведений и улучшений архитектуры. Если же вам нужна видеокарта сегодня… Что ж, для разрешения 1920х1080 и 2560х1440 GTX 970 отлично подходит. Она тихая, отлично гонится, не занимает много места и не требует супер навороченный блок питания.

Что касается памяти и споров 4 гигабайта или 3.5 — знаете, если бы NVIDIA вообще заблокировала этот кусок памяти и написала на видеокарта 3.5 ГБ — было бы намного хуже. Будь я на месте высокого начальства — продавал бы видеокарты с заявленными 3.5 ГБ и фактическими 4, такими, какие они есть сейчас. Как только это бы вскрылось — фанаты бы на руках носили компанию, мол, дарят 512 памяти. Пусть и не быстрой. Но дарят. На халяву! Ну а производительность… честно, в пылу сражений Battlefield’а или Far Cry вы не увидите разницу между «очень высокими» настройками текстур и просто «высокими», и никогда не увидите оверхэд. А во всех остальных играх можно смело ставить максимум. 🙂

А для фанатов bleeding edge технологий, 4К2К и прочих прелестей неограниченных бюджетов есть всякие Titan’ы и прочие R9 295X2. Пусть покупают и радуются. 🙂

Выводы

Выводы каждый волен делать самостоятельно. Как по мне, так истерика с памятью в GTX 970 была надуманной: на производительности это практически не сказывается, а будущее обновление драйверов и патчи к играм позволят что-нибудь подшаманить таким образом, чтобы владельцы GTX 970 не испытывали вообще никаких неудобств.

Что касается соотношения цены и производительности, то здесь, мне кажется, вариант с R9 280X… куда вы меня тащ…